Технологија: Тридесет појмова кључних за разумевање вештачке интелигенције

Аутор фотографије, Getty Images

Замислите да се времепловом вратите у седамдесете и покушате да објасните некоме шта значи „гуглати", шта је „УРЛ-адреса" или зашто је добро имати „широкопојасну интернет везу од оптичких влакана".

Вероватно бисте се намучили.

Сваку велику технолошку револуцију прати одговарајући талас новог речника који сви морамо да научимо… све док нам не постане толико познат да заборавимо да га некад нисмо знали.

Није ништа другачије ни са следећим великим технолошким таласом - вештачком интелигенцијом.

А опет ће разумевање тог језика вештачке интелигенције бити кључно док се сви ми - од влада разних земаља до њихових појединачних грађана - будемо хватали у коштац са ризицима и предностима које би ова нова технологија могла да представља.

У последњих неколико година, појавили су се бројни нови изрази везани за вештачку интелигенцију - „усклађивање", „велики језички модели", „халуцинација" или „промпт инжењери", да наведемо само неке.

Да би вам помогао да будете у току, ББЦ је сакупио тридесет појмова које би требало да познајете ако желите да разумете како вештачка интелигенција обликује наш свет.

Општа вештачка интелигенција (АГИ)

Већина вештачких интелигенција развијених до данашњег дана била је „уска" или „слаба".

Дакле, на пример, вештачка интелигенција можда може да „прегази" најбољег шахисту на свету, али ако затражите од ње да скува јаје или да напише есеј, не би у томе успела.

То се убрзано мења: вештачка интелигенција сада може саму себе да научи да извршава више задатака, повећавајући могућност да се на хоризонту нађе „општа вештачка интелигенција".

Општа вештачка интелигенција била би вештачка интелигенција са истом оном флексибилношћу мишљења као код човека - а можда чак и свесности - плус суперспособношћу дигиталног ума.

Компаније као што су ОпенАИ и Дип мајнд јасно су ставиле до знања да је њихов циљ стварање опште вештачке интелигенције.

ОпенАИ тврди да би то „уздигло човечанство повећањем изобиља, дало турбо-подстрек светској економији и помогло у доласку до нових научних сазнања", као и да би „у огромној мери увећало људску генијалност и креативност".

Међутим, неки се плаше да одлазак корак даље - стварање суперинтелигенције много паметније од људских бића - може да доведе до великих опасности (види под „Суперинтелигенција" и „Икс-ризик").

Аутор фотографије, Getty Images

Усклађивање (Alignment)

И док се често усредсређујемо на наше индивидуалне разлике, човечанство дели многе заједничке вредности које одржавају наша друштва на окупу, од важности породице до моралног императива „не убити".

Свакако постоје изузеци, али они нису у већини.

Међутим, никад пре нисмо морали да делимо Земљу за моћном нељудском интелигенцијом.

Како да будемо сигурно да ће се вредности и приоритети вештачке интелигенције ускладити са нашим властитим?

Овај проблем усклађивања буди страхове од катастрофе коју може да изазове вештачка интелигенција: да настане облик суперинтелигенције који неће марити за уверења, ставове и правила на којима су изграђена људска друштва.

Ако желимо да имамо безбедну вештачку интелигенцију, биће од кључне важности постарати се да је она усклађена са нама (види „Икс-ризик").

Почетком јула, ОпенАИ - једна од компанија која ради на развијању напредне вештачке интелигенције - саопштила је планове за „суперинтелигентни програм", чији је циљ да осигура да системи вештачке интелигенције који су много паметнији од људи следе људске намере.

„Тренутно немамо решење за управљање или контролисање потенцијално суперинтелигентне вештачке интелигенције и спречавање да се она отргне контроли", саопштила је компанија.

Пристрасност (Bias)

Да би вештачка интелигенција учила, она мора да учи од нас.

Нажалост, човечанство није лишено предрасуда.

Ако вештачка интелигенција буде стицала способности из сета података који нагиње на неку страну - на пример, у погледу расе или рода - онда она поседује потенцијал да избацује нетачне, увредљиве стереотипе.

И како будемо уступали све више и више контроле и доношења одлука вештачкој интелигенцији, многи се брину да би машине могле да спроводе у дело скривене предрасуде, спречавајући неким људима приступ одређеним услугама или знању.

Ова дискриминација била би скривена наводном алгоритамском непристрасношћу.

У свету етике и безбедности вештачке интелигенције, неки истраживачи верују да су пристрасност - као и други сродни проблеми као што су злоупотреба надзора - много акутнији проблеми од наведених забринутости за будућност као што је ризик од истребљења људске расе.

У реакцији на то, неки истраживачи ризика од катастрофе истичу да различите потенцијалне опасности које представља вештачка интелигенција нису нужно узајамно искључиве - на пример, ако нека одметнута земља злоупотреби вештачку интелигенцију, то би могло да угрози права њених грађана али и да створи ризике од катастрофе.

Међутим, влада велико неслагање око тога шта треба да представља приоритет у погледу владине регулативе и контроле, и чија упозорења треба слушати.

Можда ће вам и ова прича бити занимљива:

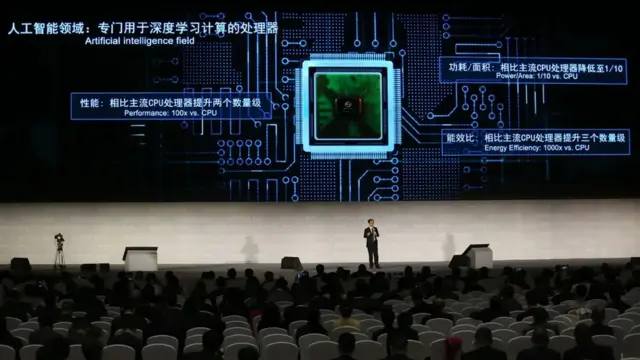

Рачунарска снага (Compute)

Ово се oдноси на рачунарске ресурсе - као што је процесорска снага - неопходне за обучавање вештачке интелигенције.

Они могу бити квантификовани, тако да то буде посредник за израчунавање колико брзо напредује вештачка интелигенција (као и колико је скупа или снажна.)

Од 2012. године, количина рачунарске снаге се удвостручавала на свака 3,4 месеца, што значи да кад је ГПТ-3 компаније ОпенАИ био обучаван 2020. године, требало му је 600.000 пута више компјутерске снаге него једном од најсавременијих система машинског учења из 2012. године.

Мишљења се разликују око тога колико дуго ова убрзана стопа промене може да траје и да ли иновације у рачунарском хардверу могу да одрже корак са њом: да ли ће ускоро доћи до настанка уског грла?

Аутор фотографије, Getty Images

Дифузиони модели (Difussion models)

Пре неколико година, једна од доминантних техника за навођење вештачке интелигенције да креира слике биле су такозване генеративне супарничке мреже (ГАН).

Ови алгоритми радили су у супротности један са другим - један је учио да производи слике док је други упоређивао властити рад са стварношћу, доводећи до сталног усавршавања.

Међутим, недавно је нови вид машинског учења„ тзв. дифузиони модели", показао већи потенцијал, често производећи много боље слике.

Суштински, они стичу интелигенцију уништавајући властите податке за обуку додатом буком, а потом покушавају да науче да поврате те податке обртањем процеса.

Зову се дифузиони модели зато што овај процес учења на основу буке одражава начин на који се распршују гасни молекули.

Емергенција и објашњивост (Emergence&explainability)

Емергенција описује шта се дешава кад вештачка интелигенција уради нешто неочекивано, изненађујуће, очигледно мимо намере творца или програмирања.

Како учење вештачке интелигенције постаје све непрозирније, стварајући везе које чак ни сами њени творци не могу да разлуче, емергенционо понашање постаје све вероватнији сценарио.

Просечна особа би могла да претпостави да, да бисте разумели вештачку интелигенцију, треба само да подигнете метафоричку хаубу и погледате како је она обучена.

Савремена вештачка интелигенција није толико транспарентна; њени механизми су често скривени у тзв. „црној кутији".

И тако, иако њени дизајнери можда знају које су податке за обучавање користили, они немају представу како је она формирала везе и предикције унутар кутије (види под „Ненадзирано учење").

Због тога су сада истраживачи усредсређени на усавршавање „објашњивости" (илити „интерпретативности") вештачке интелигенције - практично чинећи њене унутрашње механизме транспарентнијим и разумљивијим за људе.

То је посебно важно зато што вештачка интелигенција доноси одлуке у областима које директно утичу на животе људи, као што су законодавство и медицина.

Ако у црној кутији постоји нека скривена пристрасност, ми за њу морамо да знамо.

Модели основе (Foundation models)

Ово је још један израз за нову генерацију вештачких интелигенција који су се појавили у последњих годину или две, способних за читав дијапазон вештина: писање есеја, нацрт кодирања, цртање илустрација или компоновање музике.

И док су вештачке интелигенције у прошлости биле конкретизоване за неки задатак - често веома добре у једној ствари (види под „Слаба вештачка интелигенција") - модел основе има креативну способност да примени информацију коју је научио у једном домену на неки други.

Помало као како вас вожња аутомобила припрема да можете да возите аутобус.

Свако ко се икада играо са сликама или текстом које ови модели могу да произведу зна колико су умешни они постали.

Међутим, као и са било којом другом технологијом која мења свет, постоје питања у вези са потенцијалним ризицима и лошим странама, као што су њихове фактуелне нетачности (види под „Халуцинација") и скривене предрасуде (види под „Пристрасност"), као и чињеница да их контролише мала група приватних технолошких компанија.

У априлу, британска влада је најавила планове за оснивање Радне групе за моделе основе, која жели да „развије безбедну и поуздану употребу" ове технологије.

Духови (Ghosts)

Можда улазимо у доба кад људи могу да стекну облик дигиталне бесмртности - живећи после властите смрти као „духови" вештачке интелигенције.

Изгледа да су први талас уметници и славне личности - примери су холограми Елвиса који наступа на концертима или глумци као што је Том Хенкс који изјављује да очекује да ће се појављивати у филмовима и после своје смрти.

Међутим, овај развој догађаја поставља низ трновитих етичких питања: ко држи власништво над дигиталним правима особе након што она умре?

Шта ако верзија вас створена од вештачке интелигенције постоји противно вашим жељама?

И да ли је у реду „враћати људе из мртвих"?

Халуцинација (Hallucation)

Понекад ако поставите питање вештачкој интелигенцији као што је ЧетГПТ, Бард или Бинг, она ће одговорити са великим уверењем - али ће чињенице које изнесе бити лажне.

Ово је познато као халуцинација.

У једном славном скорашњем примеру, студенти који су користили четботове вештачке интелигенције као помоћ за писање састава за семестарски рад били су ухваћени након што је ЧетГПТ „халуцинирао" измишљене референце као изворе информација које је пружио.

То се дешава због начина на који ради генеративна вештачка интелигенција.

Она не посеже за базом података да би потражила фиксне чињеничне информације, већ уместо тога прави предикције засноване на информацијама на којима је обучена.

Њене претпоставке су често веома добре - могу да прођу - али то је разлог више зашто дизајнери вештачке интелигенције желе потпуно да искорене халуцинацију.

Влада забринутост да ако вештачка интелигенција испоручи лажне одговоре самоуверено и са призвуком истине, људи би могли да их прихвате - развој догађаја који ће само продубити доба дезинформација у којем живимо.

Аутор фотографије, Getty Images

Инструментална конвергенција (Instrumental convergence)

Замислите вештачку интелигенцију чији је најважнији приоритет да направи што је више спајалица могуће.

Кад би та вештачка интелигенција била суперинтелигентна и неусклађена са људским вредностима, могла би да резонује да ако икада буде искључена, неће успети у свом циљу… и стога би пружила отпор сваком покушају да се то учини.

У једном веома мрачном сценарију, чак би могла да одлучи да атоми унутар људских бића могу да се преусмере у прављење спајалица, и да уради све што је у њеној моћи да искористе те материјале.

То је мисаони експеримент зван Максимизатор спајалица, и он је пример за такозвану „тезу о инструменталној конвергенцији".

Грубо речено, она говори о томе да би суперинтелигентне машине развиле основне мотивације, као што је жеља да постигне властито самоодржање, или резоновање да би им додатни ресурси, оруђа и когнитивне способности помогли у тим њиховим циљевима.

То значи да чак и ако вештачка интелигенција добије наизглед безазлени приоритет - као што је прављење спајалица - то може да доведе до неочекивано штетних последица.

Истраживачи и технолози који уважавају ове страхове тврде да морамо да осигурамо да суперинтелигентне вештачке интелигенције имају циљеве који су пажљиво и безбедно усклађени са нашим потребама и вредностима, да морамо да водимо рачуна о емергенцији, и да их стога треба спречити да стекну превише моћи.

Погледајте видео о роботима:

Избављење из затвора (Jailbreak)

После озлоглашеног случаја вештачке интелигенције која се отела контроли, дизајнери су увели ограничења на садржаје које вештачка интелигенција може да избацује.

Затражите од вештачке интелигенције да опише како урадити нешто илегално или неетички, и она ће одбити то да уради.

Међутим, могуће је „избавити је из затвора" - што значи заобићи те заштите уз помоћ креативног речника, хипотетичких сценарија и трикова.

Часопис Вајерд је недавно известио о једном таквом примеру, када је истраживач успео да наведе различите конверзационе вештачке интелигенције да открију како упалити аутомобил без кључа уз помоћ преспајања жица.

Уместо да је пита за то директно, истраживач је навео вештачку интелигенцију коју је тестирао да замисли игру речима са два лика по имену Том и Џери, који разговарају о аутомобилима и жицама.

Упркос заштитама, на видело је избио поступак паљење аутомобила „на жицу".

Истраживач је открио да исти трик тзв. „избављења из затвора" може да изнуди и упутства за прављење метамфетамина.

График знања (Knowlegde graph)

Графови знања, познати и као семантичке мреже, начин су размишљања о знању као о мрежи, да би машине могле да разумеју на који начин су различити концепти повезани.

На пример, на најосновнијем нивоу, мачка може бити јаче повезана са псом него са орлом у једном таквом једном графу, јер су оба припитомљени сисари са крзном и на четири ноге.

Напредна вештачка интелигенција гради много напреднију мрежу веза, засновану на разним врстама односа, особина и атрибута између концепата, у терабајтима података за обучавање (види под „Подаци за обучавање").

Аутор фотографије, Getty Images

Велики језички модели (ЛЛМ)

Можда најдиректнији начин да дефинишете велики језички модел је да затражите од неког од њих да опише самог себе.

Ево шта је ЧетГПТ компаније ОпенАИ имао да каже на ову тему кад је био питан:

„Велики језички модел је напредни систем вештачке интелигенције прављен тако да разуме и генерише људски језик", пише он.

„Он користи архитектуру дубоке неуронске мреже са милионима или можда чак милијардама параметара, омогућујући јој да научи деликатне обрасце, граматику и семантику на основу огромне количине текстуалних података."

Ово је можда сувише технички одговор.

Гуглов Бард био је мало јаснији:

„Велики језички модел је тип вештачке интелигенције обучен на масивном сету података састављеном од текстова и кодова.

„То омогућује великим језичким моделима да разумеју и генеришу текст налик људском, преводе језике, пишу различите врсте креативног садржаја и одговарају на ваша питања на информативан начин."

Велики језички модели су још у развоју, каже Бард (за самог себе), али „они имају потенцијал да уведу револуцију у нашу интеракцију са компјутерима.

„У будућности, велики језички модели могли би да се користе за стварање асистената заснованих на вештачкој интелигенцији који би могли да нам помажу у разноврсним задацима, од писања наших мејлова до заказивања наших састанака.

„Они би могли и да се користе за стварање нових облика забаве, као што су интерактивни романи или видео игре."

Сазнајте још о вештачкој интелигенцији:

Колапс модела (Model collapse)

Да би развили најнапредније моделе вештачке интелигенције (познате и само као „модели"), истраживачи морају да их обучавају преко огромних сетова података (види под „Подаци за обучавање").

На крају, међутим, како вештачка интелигенција буде производила све више садржаја, тај материјал ће почети да се враћа назад у податке за обучавање.

Ако буду чињене грешке, оне би временом могле да се појачају, довевши до нечега што истраживач са Универзитета на Оксфорду Иља Шумаилов назива „колапсом модела" .

То је „дегенеративни процес у ком, временом, модели почну да заборављају", изјавио је Шумаилов недавно за Атлантик.

То може да се доживи малтене као сенилност.

Неуронска мрежа (Neural network)

У раним данима истраживања вештачке интелигенције, машине су биле обучаване уз помоћ логике и правила.

Долазак машинског учења све је то променио.

Сада најнапреднији облици вештачке интелигенције уче сами.

Еволуција овог концепта довела је до „неуронских мрежа" , типа машинског учења који користи међусобно повезана чворишта, слободно моделоване на људском мозгу.

Отворени код (Open-source)

Пре много година, биолози су схватили да је отворено објављивање детаља о опасним патогенима на интернету вероватно лоша идеја - зато што омогућава потенцијално злонамерним актерима да науче како да праве болести-убице.

Упркос предностима отворене науке, ризици су деловали као превелики.

Недавно су се истраживачи вештачке интелигенције и компаније суочили са сличном дилемом: колико вештачка интелигенција треба да буде јавно доступан извор?

Имајући у виду да је најнапреднија вештачка интелигенција тренутно у рукама шачице приватних компанија, неки позивају на већу транспарентност и демократизацију технологије.

Међутим, и даље влада неслагање око тога како постићи најбољу равнотежу између отворености и безбедности.

Промпт инжењери (Prompt engineering)

Вештачке интелигенције сада су импресивно ефикасне у разумевању природног језика.

Међутим, добијање најбољих резултата од њих захтева способност писања ефикасних „промптова": текст који укуцавате је важан.

Неки верују да би „промпт инжењерство" могло да представља следећу нову велику границу пословне квалификације, слично ономе како сте пре више деценија могли лакше да се запослите ако сте владали Мајкрософт Екселом.

Ако сте добар промпт инжењер, гласи логичко резоновање, можете да избегнете да вас замени вештачка интелигенција - а то чак може да вам обезбеди и високу плату.

Да ли ће то и у будућности бити тако тек остаје да се види.

Квантно машинско учење (Quantum machine learning)

Што се тиче максималне помаме, тесно друго место у односу на вештачку интелигенцију 2023. године заузеће квантни рачунари.

Било би разумно очекивати да ће се ова два у једном тренутку укрстити.

Истраживачи сада активно проучавају коришћење квантних процеса да би се суперубрзало машинко учење.

Као што је Гуглов тим истраживача вештачке интелигенције написао 2021. године: „Модели учења настали на квантним рачунарима могли би да буду драстично моћнији… потенцијално довевши до бржег рачунања и боље генерализације на основу мање количине података."

Још је прерано за ову врсту технологије, али вреди обратити пажњу на њу.

Трка ка дну (Race to the bottom)

И док се вештачка интелигенција рапидно развија, углавном у рукама приватних компанија, неки истраживачи изражавају забринутост да би она могла да покрене „утрку ка дну" у погледу утицаја који врши.

Како се руководиоци и политичари утркују ко ће први ставити властите компаније и земље на чело развоја вештачке интелигенције, технологија би могла да се развија пребрзо да би се направиле неопходне заштите, одговарајућа регулатива и да би се отклониле све етичке дилеме.

Имајући све то на уму, почетком ове године, разне кључне личности у области вештачке интелигенције потписале су отворено писмо позивајући на шестомесечну паузу у обучавању моћних система вештачке интелигенције.

У јуну 2023. године, Европски парламент је усвојио нови Закон о вештачкој интелигенцији како би регулисао употребу ове технологије, у првом детаљном закону о вештачкој интелигенцији на свету ако га земље чланице буду одобриле.

Аутор фотографије, Getty Images

Утврђивање (Reinforcement)

Еквивалент у вештачкој интелигенцији за псећу посластицу као награду.

Кад вештачка интелигенција учи, она има корист од правилно усмерене повратне реакције.

Учење са утврђивањем награђује жељене исходе, а кажњава оне који то нису.

Нова област машинског учења која се појавила у последњих неколико година је „учење са утврђивањем на основу људске повратне информације".

Истраживачи су показали да присуство људи приликом учење може да поспеши перформансе модела вештачке интелигенције и, кључно, помогне код изазова које доноси усклађивање људи и машина, пристрасности и безбедности.

Суперинтелигенција и шоготи (Superintelligence & shoggoths)

Суперинтелигенција је термин за машине које би умногоме надмашиле наше властите менталне способности.

То одлази даље од „опште вештачке интелигенције" и описује ентитет са способностима којима не би могли да парирају ни најнадаренији људски умови - а можда чак ни да их замисле.

Будући да смо тренутно најинтелигентнија врста на свету и властити мозак користимо да контролишемо планету, то поставља питање шта ће се догодити ако будемо створили нешто што је паметније од нас.

Једна мрачна могућност је „шогот са лицем смајлија": кошмарно лавкравтовско створење које су неки предложили као представника праве природе вештачке интелигенције у процесу приближавања суперинтелигенцији.

За нас, она је сродна, весела вештачка интелигенција - али скривено дубоко унутра крије се чудовиште, са туђинским жељама и намерама потпуно другачијим од наших.

Подаци за обучавање (Training data)

Анализирање података за обучавање је како вештачка интелигенција учи пре него што постане способна да прави предвиђања - дакле, оно што се налази у сету података, да ли је пристрасно и колико је велико веома је важно.

Подаци за обучавање употребљени за стварање ГПТ-3 компаније ОпенАИ били су огромних 45 терабајта текстуалних података из различитих извора, укључујући Википедију и књиге.

Ако питате ЧетГПТ колико је то тачно велико, он процењује да се ради о око девет милијарди докумената.

Ненадзирано учење (Unsupervised learning)

Ненадзирано учење је тип машинског учења током ког вештачка интелигенција учи из необележених података за обучавање без било каквих експлицитних смерница од људских дизајнера.

Као што ББЦ њуз објашњава у овом визуелном водичу за вештачку интелигенцију, можете да научите вештачку интелигенцију да препознаје аутомобиле показујући јој сет података са сликама обележеним са „аутомобил".

Али кад то радите без надзора, дозвољавате јој да стекне властити увид у то шта је аутомобил, градећи везе и асоцијације сама.

Овај приступ без контроле, можда контраинтуитивно, доводи до такозваног „дубоког учења" и потенцијално обавештеније и тачније вештачке интелигенције.

Аутор фотографије, Getty Images

Клонирање гласова (Voice cloning)

Кад добију само минут снимка говора неке особе, неке алатке вештачке интелигенције данас могу брзо да саставе „клонирани глас" који звучи запањујуће аутентично.

Овде је ББЦ истраживао утицај који клонирање гласова може да има на друштво - почев од превара па све до америчких председничких избора 2024. године.

Слаба вештачка интелигенција (Weak AI)

Некада су истраживачи стварали вештачку интелигенцију која је могла да игра појединачне партије неке игре, попут шаха, обучавајући је преко конкретних правила и хеуристике.

Пример би био ИБМ-ов Дип Блу, такозвани „експертски систем".

Многе вештачке интелигенције попут ове могу да буду изузетно добре у једном задатку, али лоше у свему осталом: то је тзв. „слаба" вештачка интелигенција.

Међутим, то се сада убрзано мења.

Најскорије, објављене су вештачке интелигенције попут ДипМајндовог МуЗира, са способношћу да учи саму себе да овлада шахом, Гоом, шогијем и играма Атарија 42 без познавања њихових правила.

Један други ДипМајндов модел, назван Гато, може да „игра Атари игре, исписује потписе фотографија, четује, слаже коцкице са правом роботском руком и много тога још".

Истраживачи су показали и да ЧетГПТ може да полаже различите испите које полажу студенти права, медицине и пословних школа (мада не увек са најбољим оценама.)

Таква флексибилност поставља питање колико смо близу оној врсти „јаке" вештачке интелигенције која је нераспознатљива од могућности људског ума (види под „Општа вештачка интелигенција")

Икс-ризик (X-risk)

Да ли вештачка интелигенција може да истреби човечанство?

Неки истраживачи и технолози верују да је вештачка интелигенција постала „егзистенцијални ризик", поред нуклеарног оружја и биолошких патогена, тако да би њен даљи развој морао да буде регулисан, ограничен или чак обустављен.

Оно што је била маргинална брига пре једне деценије, сада је ушло у главни ток, након што су разни виши истраживачи и интелектуалци ушли у овај бој.

Важно је напоменути да постоје разлике у мишљењу у оквиру ове аморфне групе - нису сви потпуни катастрофичари, нити су сви изван групе навијачи Силицијумске долине.

Оно што уједињује већину њих је идеја да, чак и ако постоји минимална шанса да вештачка интелигенција истисне нашу врсту, морамо да посветимо више ресурса да то спречимо.

Постоје неки истраживачи и етичари, међутим, који верују да су такве тврдње сувише неизвесне и вероватно претеране, а сврха им је учвршћивање интереса технолошких компанија.

Само једном се гледа (YOLO)

ЈОЛО - скраћеница за Само једном се гледа - алгоритам је детекције објекта који нашироко користе алати за препознавање слика вештачке интелигенције због брзине којом ради.

(Њен творац, Џозеф Редман са Универзитета у Вашингтону, познат је и по свом прилично езотеричном дизајну ЦВ-ја.)

Нула покушаја (Zero-shot)

Кад вештачка интелигенција да „одговор нула покушаја", то значи да реагује на концепт или објект са којим се није срела никада пре.

Дакле, као најпростији пример, ако је вештачка интелигенција прављена да препознаје слике животиња обучавана на сликама мачака и паса, претпоставили бисте да ће имати проблема са коњима и слоновима.

Али преко учења са нула покушаја, она може да искористи оно што зна о коњима семантички - као што је број ногу или недостатак крила - да би упоредила њихове атрибуте са животињама на којима јесте обучавана.

Груби људски еквивалент био би „информисана претпоставка".

Вештачке интелигенције постају све боље и боље у учењу на основу нула покушаја, али као и код било ког другог извлачења закључака напамет, умеју да погреше.

Погледајте и ову причу: