AIが人類滅亡を招く恐れ 専門家やテック企業トップが警告

クリス・ヴァランス、テクノロジー記者

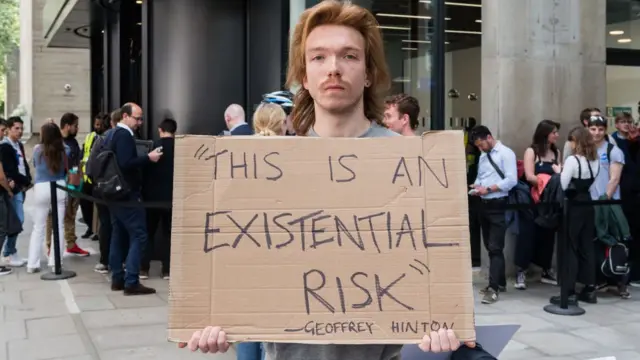

画像提供, Future Publishing/Getty Images

人工知能(AI)が人類滅亡を招く恐れがあると、専門家らが警告を発している。

ウェブサイト「センター・オブ・AIセーフティー」に掲載されたAIのリスクについての声明文には、「チャットGPT」を開発したオープンAIのサム・アルトマン最高経営責任者(CEO)、グーグル・ディープマインドのデミス・ハッサビスCEO、アンソロピックのダリオ・アモデイCEOといった、テクノロジー企業のトップも署名している。

声明は、「パンデミックや核戦争といった社会規模のリスクと同様、AIによる絶滅のリスクを低減することを世界的な優先事項とするべきだ」と呼びかけている。

一方で、こうした懸念は大げさだという意見もある。

「センター・オブ・AIセーフティー」は、いくつかの惨事シナリオを想定している。

- AIの兵器化:新薬開発ツールが化学兵器の製造に使われるといった可能性

- AIで生成された偽情報が社会を不安定化させ、「集団での意思決定に害を及ぼす」可能性

- AIの力がより少数の人に集中し、国家が「監視と抑圧的な検閲を通じて、狭い価値観を強制」できるようになる可能性

- 「映画『ウォーリー』で描かれたシナリオのように」、人類がAIに頼って衰退する可能性

人間を超えた知能を持つ「スーパーインテリジェンス(超知能)」AIによるリスクを以前から指摘していたジェフリー・ヒントン博士や、モントリオール大学のヨシュア・ベンジオ教授(コンピューター科学)も、この声明を支持している。

ヒントン博士とベンジオ教授、そして米ニューヨーク大学のヤン・ルカン教授は、この領域の先駆者として「AIの父」と呼ばれている。2018年には、コンピューター・サイエンスに目覚ましい貢献をした人に贈られるチューリング賞を受賞している。

しかし、フェイスブックやインスタグラムを運営するメタにも所属しているルカン教授は、こうしたこの世の終わりのような警告は誇張されすぎているとし、「こうした予言に対するAI研究者の最も一般的な反応は、やれやれと手で顔を覆うことだ」とツイートした。

画像提供, EPA

「現実を分裂させる」

多くの専門家が、AIが人類を滅ぼすという懸念は非現実的で、システム上の偏りなど、すでにある問題から目をそらすものだとしている。

米プリンストン大学のアーヴィンド・ナラヤナン氏は以前、BBCの取材で、サイエンスフィクション(SF)のような惨事が起きるシナリオは非現実的だと話していた。

「現在のAIの能力は、こうしたリスクを実現するには程遠い。結果として、短期的なAIによる害から関心をそらしてしまっている」

英オックスフォード大学AI倫理研究所のエリザベス・レニエリス氏も、もっと現在に近いリスクの方が心配だと語った。

「AIの進歩によって、偏った、差別的な、排除的な、あるいはその他の不公正な自動意思決定の規模が拡大すると同時に、そうした過程が不可解で証明不可能なものになるだろう」

レニエリス氏はまた、AIが「偽情報の量と拡散を急加速させ、その結果として現実が分裂し、公の信頼が壊されるだろう。特に、デジタルの分断で間違った側にいる人たちへの不平等が加速するだろう」と述べた。

レニエリス氏によると、多くのAIツールは「これまでの人類の経験」に「ただ乗り」している。AIの多くは、人間が作成したコンテンツや文章、アート、音楽によって訓練され、それを模倣(もほう)する。その結果として、AIの制作者は「莫大な富と権力を公共の場からほんの一握りの私企業に移譲してしまった」。

しかし、「センター・オブ・AIセーフティー」のダン・ヘンドリクス所長はBBCニュースに対し、未来のリスクと現在の懸念を「相反するものとして見るべきではない」と話した。

「今日の問題を解決することは、多くの未来のリスクの解決にも役立つ」

スーパーインテリジェンス開発

専門家や米テスラのイーロン・マスク氏といったテック企業のトップらは今年3月にも、次世代AIの開発を止めるよう求める公開書簡を発表している。

それ以来、AIによる「絶滅」の脅威に関する報道は加速している。

この公開書簡では、「いずれ我々を数で超え、能力で超え、我々を陳腐な存在にし、我々に取って代わるかもしれない非人間的な知能を開発する」べきなのかと疑問を呈している。

これに対し、今回の声明は非常に短いもので、「対話を広げる」のが目的だとしている。

声明では、AIによるリスクを核戦争と比較している。オープンAIも最近公開したブログ投稿で、スーパーインテリジェンスは原子力と似た方法で規制されるかもしれないと示唆している。

「我々はやがて、スーパーインテリジェンス開発について国際原子力機関(IAEA)のようなものが必要になるかもしれない」

「安心してほしい」

オープンAIのアルトマンCEOやグーグルのスンダル・ピチャイCEOらは先に、AI規制についてイギリスのリシ・スーナク首相と意見を交わしている。

スーナク首相はこうしたAIリスクに関する警告について経済や社会への利益もあると強調した。

「最近では、AIが半身不随の人の歩行を助けたり、新しい抗生物質を発見したりしている。こうしたことが安全で確実な方法で行われるようにする必要がある」

「国民には、政府が非常に慎重に検討しているのだと安心してもらいたい」

スーナク氏は、先に広島で行われた主要7カ国首脳会議(G7サミット)でも、AIについて協議した。また、近くアメリカを訪問してこの問題を話し合うと言う。

G7は最近、AIに関する作業部会を設立した。