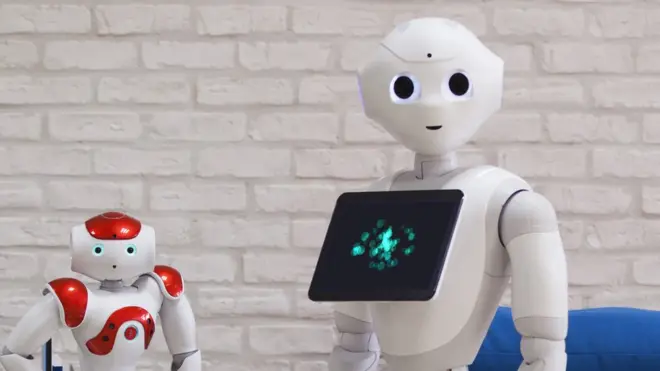

Експерти закликають заборонити "роботів-убивць"

Автор фото, Getty Images

Більш як 100 провідних експертів з роботів застерігають ООН вжити заходів, щоби запобігти розвиткові "роботів-убивць".

У листі до організації провідні фахівці у галузі штучного інтелекту, зокрема мільярдер Ілон Маск та один із засновників компанії DeepMind Мустафа Сулейман, попередили про можливу "третю революцію возброєнні".

"Летальна автономна" технологія - це "скринька Пандори", і час тут має велике значення.

116 експертів закликають ООН заборонити використання штучного інтелекту для керування зброєю.

"Коли таку технологію розроблять, збройні конфлікти можуть розвернутися у такому масштабі, якого (людство) ще не бачило, і з часом розвиватимуться швидше, ніж це зможе усвідомити людина", - йдеться в листі.

"Це може бути зброя терору, зброя, яку деспоти й терористи використовуватимуть проти ні в чому неповинних людей, і зброя, систему якої можна заламати, щоби використати у небажаних цілях", - пояснюється в тексті звернення.

Лист від експертів із технологій написаний стривоженим тоном і попереджає, що "в нас немає часу думати довго".

"Коли скриньку Пандори відкрити, закрити її буде дуже важко".

Експерти називають технологію автономної зброї "морально неправильною" і закликають занести її у список зброї, забороненої ООН.

Зустріч групи ООН щодо автономного озброєння була запланована на понеділок, але її відклали до листопада.

Раніше у комітетах ООН обговорювали можливу заборону на технологію "роботів-вбивць".

У 2015 більше від тисячі експертів, науковців та дослідників, зокрема Стівен Гокінг, Ілон Маск та співзасновник Apple Стів Возняк, опублікували лист, в якому попереджали про небезпеку застосування автономної зброї.

Що таке "робот-вбивця"?

Робот-вбивця - це повністю автоматизовна зброя, яка може обирати й уражати цілі без втручання людини. Зараз такої технології не існує, але прогрес в розвитку технологій наближає її появу.

Прибічники роботів-вбивць упевнені, що чинних законів, які регулюють військові дії, цілком достатньо, аби вирішити будь-які проблеми, пов'язані із застосуванням технології. А також, що у разі виникнення непередбаченої ситуації, на технологію потрібно буде накласти мораторій, а не жорстку заборону.

Однак противники технології стверджують, що вона становить загрозу людству, і всі автоматичні "функції вбивства" слід заборонити.