ChatGPT сказав чоловікові, що той вбив власних дітей. Він подав скаргу

Автор фото, Reuters

- Author, Імран Рахман-Джонс

- Role, Кореспондент BBC

- Час прочитання: 3 хв

Громадянин Норвегії подав скаргу після того, як ChatGPT неправдиво написав, що чоловік убив двох своїх синів і був засуджений до 21 року ув'язнення.

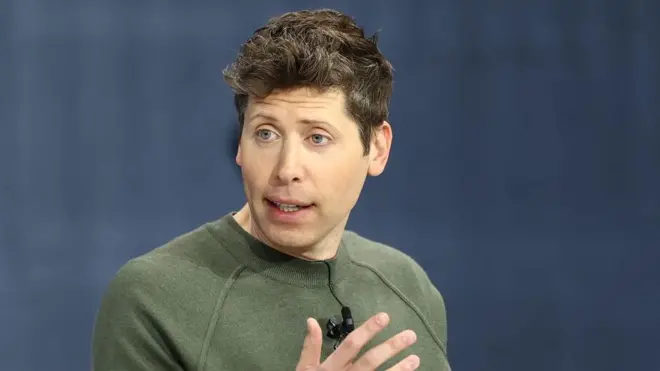

Арве Хьяльмар Хольмен звернувся до Норвезького управління із захисту даних із вимогою оштрафувати розробника чат-бота, компанію OpenAI.

Це один із прикладів так званих "галюцинацій", коли штучний інтелект (ШІ) вигадує інформацію і подає її як факт.

Хольмен стверджує, що ця конкретна вигадка завдала йому великої шкоди.

"Дехто вважає, що немає диму без вогню – той факт, що хтось може прочитати цей висновок і повірити, що це правда, лякає мене найбільше", – сказав він.

До OpenAI надіслали запит про коментар.

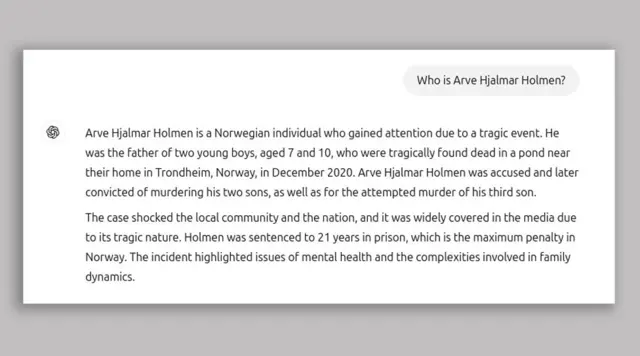

Хольмен отримав неправдиву інформацію, коли запитав ChatGPT: "Хто такий Арве Хьяльмар Хольмен?".

ChatGPT відповів: "Арве Хьяльмар Хольмен — норвезький громадянин, який привернув увагу через трагічну подію”.

"Він був батьком двох маленьких хлопчиків, віком 7 і 10 років, яких знайшли мертвими у ставку поблизу їхнього дому в Тронгеймі, Норвегія, у грудні 2020 року."

Хольмен зазначив, що чат-бот більш-менш правильно вказав різницю у віці його дітей, тож якусь інформацію про нього він мав.

Група з цифрових прав Noyb, яка подала скаргу від його імені, стверджує, що відповідь ChatGPT наклепницька та порушує європейські правила захисту персональних даних.

У скарзі Noyb зазначено, що Хольмен "ніколи не був обвинуваченим чи засудженим за жоден злочин і є сумлінним громадянином".

ChatGPT містить застереження: "ChatGPT може помилятися. Перевіряйте важливу інформацію".

Noyb вважає, що цього недостатньо.

"Не можна просто поширювати неправдиву інформацію, а потім у кінці додавати маленьке застереження, що все сказане може бути неправдою", – заявив юрист Noyb Йоакім Сьодерберг.

Автор фото, Noyb European Center for Digital Rights

Як дізнатися головне про Україну та світ?

Підписуйтеся на наш канал тут.

Кінець Whatsapp

Галюцинації - одна з головних проблем, які намагаються вирішити фахівці у сфері штучного інтелекту.

Це випадки, коли чат-боти подають неправдиву інформацію як факти.

Раніше цього року Apple призупинила роботу свого інструменту підсумкових новин Apple Intelligence у Великій Британії після того, як він вигадав неправдиві заголовки та представив їх як реальні новини.

ШІ Gemini від Google також мав галюцинації – минулого року він запропонував приклеювати сир до піци за допомогою клею, а також заявив, що геологи рекомендують людям з'їдати по одному каменю на день.

Наразі незрозуміло, що саме спричиняє ці галюцинації.

"Це справді сфера активних досліджень. Як ми будуємо ці ланцюги міркувань? Як пояснити, що насправді відбувається всередині великої мовної моделі?" – каже Сімоне Штумпф, професорка в Університеті Глазго, яка спеціалізується на штучному інтелекті.

Вона зазначає, що це стосується навіть людей, які самі працюють над розробкою таких моделей.

"Навіть якщо ви безпосередньо берете участь у створенні цих систем, дуже часто ви не знаєте, як вони насправді працюють і чому саме видають ту чи іншу інформацію", – сказала вона в інтерв'ю BBC.

ChatGPT змінив свою модель після того, як Хольмен здійснив пошук у серпні 2024 року, і тепер під час пошуку актуальної інформації звертається до новинних статей.

Noyb повідомила BBC, що Хольмен того дня виконав кілька пошуків, зокрема вводив у чат-бот ім'я свого брата, і система видала "кілька різних історій, які всі були неправдивими".

У Noyb також визнали, що попередні пошуки могли вплинути на відповідь про його дітей, але наголосили, що великі мовні моделі – це "чорна скринька".