आर्टिफ़िशियल इंटेलिजेंस से मानव सभ्यता के अंत का ख़तरा, जानकारों ने दी चेतावनी

इमेज स्रोत, FUTURE PUBLISHING/GETTY IMAGES

- Author, क्रिस वालेंस

- पदनाम, टेक्नोलॉजी रिपोर्टर

'आर्टिफ़िशियल इंटेलिजेंस से इंसानी वजूद को ख़तरा हो सकता है.' कई विशेषज्ञों ने इसे लेकर आगाह किया है. ऐसी चेतावनी देने वालों में ओपनएआई और गूगल डीपमाइंड के प्रमुख शामिल हैं.

इसे लेकर जारी बयान 'सेंटर फ़ॉर एआई सेफ़्टी' के वेबपेज़ पर छपा है. कई विशेषज्ञों ने इस बयान के साथ अपनी सहमति जाहिर की है.

विशेषज्ञों ने चेतावनी देते हुए कहा है, "समाज को प्रभावित कर सकने वाले दूसरे ख़तरों, मसलन महामारी और परमाणु युद्ध के साथ साथ एआई (आर्टिफ़िशियल इंटेलिजेंस) की वजह से वजूद पर मौजूद ख़तरे को कम करना वैश्विक प्राथमिकता होनी चाहिए."

लेकिन कई लोगों की राय है कि इसके डर को बढ़ा चढ़ाकर बताया जा रहा है.

चैटजीपीटी के चीफ़ एक्ज़ीक्यूटिव सैम ऑल्टमैन, गूगल डीपमाइंड के चीफ़ एक्ज़ीक्यूटिव डेमिस हसाबिस और एंथ्रोपिक के डैरियो अमोदेई ने बयान का समर्थन किया है.

इमेज स्रोत, Getty Images

क्या हो सकते हैं ख़तरे

- सेंटर फ़ॉर एआई सेफ़्टी वेबसाइट ने तबाही वाले कई संभावित परिदृश्यों का ज़िक्र किया है.

- एआई को हथियार की तरह इस्तेमाल किया जा सकता है- उदाहरण के लिए ड्रग डिस्कवरी टूल्स को कैमिकल वेपन्स (रासायनिक हथियार) बनाने के लिए आजमाया जा सकता है.

- एआई की मदद से तैयार ग़लत सूचनाएं समाज को अस्थिर कर सकती हैं और इससे 'सामूहिक निर्णय प्रक्रिया पर असर हो सकता है.'

- एआई की ताक़त कुछ ही हाथों में सिमट सकती है, जिससे 'सरकारें बड़े पैमाने पर लोगों की निगरानी करने और दमनकारी सेंसरशिप के लिए इस्तेमाल कर सकती हैं.'

- ऐसी स्थिति भी बन सकती है जब इंसान एआई पर निर्भर हो जाएं जैसा कि 'फ़िल्म वॉल ई में दिखाया गया था.

इमेज स्रोत, Getty Images

बढ़ा-चढ़ाकर बताया जा रहा है ख़तरा?

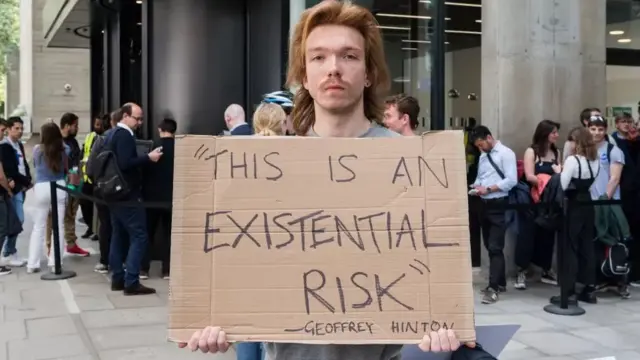

सेंटर फ़ॉर एआई सेफ़्टी की चेतावनी का डॉक्टर ज्यॉफ़री हिंटन ने भी समर्थन किया है. वो सुपर इंटेलिजेंट एआई के ख़तरों को लेकर पहले भी चेतावनी जारी कर चुके हैं

यूनिवर्सिटी ऑफ़ मोंट्रियल में कंप्यूटर साइंस के प्रोफ़ेसर योशुआ बेंजो ने भी बयान पर दस्तख़त किए हैं.

डॉक्टर हिंटन, प्रोफ़ेसर बेंजो और प्रोफ़ेसर यान लेकन को 'एआई का गॉडफादर' कहा जाता है. इसकी वजह है इस क्षेत्र में उनका उल्लेखनीय काम.

इसके लिए इन्हें साल 2018 में संयुक्त रुप से 'टर्निंग अवॉर्ड' दिया गया था. ये पुरस्कार कंप्यूटर साइंस के क्षेत्र में उल्लेखनीय योगदान के लिए दिया जाता है.

प्रोफ़ेसर लेकन मेटा के लिए भी काम करते हैं. वो कहते हैं कि ये सर्वनाश से जुड़ी ये चेतावनी बढ़ा चढ़ाकर बताई जा रही है.

उन्होंने ट्विटर पर लिखा, "विनाश की इन भविष्यवाणियों को लेकर एआई शोधकर्ताओं की सबसे आम प्रतिक्रिया चेहरे पर हथेली रखने जैसी है."

कई दूसरे विशेषज्ञों की राय भी ऐसी ही है. वो कहते हैं कि एआई मानवता को ख़त्म कर देगी, ये डर वास्तविक नहीं है. ये बातें सिस्टम में पहले से मौजूद पूर्वाग्रह जैसी दिक्कतों से ध्यान हटा सकती हैं.

प्रिंसटन यूनिवर्सिटी में कंप्यूटर वैज्ञानिक अरविंद नारायणन ने बीबीसी से कहा था कि साई फ़ाई जैसा विनाशकारी घटनाक्रम वास्तविक नहीं है.

उनके मुताबिक, "मौजूदा एआई ऐसे जोखिमों के सच में तब्दील होने की क्षमता नहीं रखता है. नतीजतन, ये हाल फिलहाल एआई से हो सकने वाले नुक़सान की ओर से ध्यान हटा रहा है."

ऑक्सफ़ोर्ड इंस्टीट्यूट फ़ॉर एथिक्स इन एआई की सीनियर रिसर्च एसोसिएट एलिजाबेथ रेनिएरिस ने बीबीसी से कहा कि वो मौजूदा वक़्त के करीबी दौर के ख़तरों को लेकर ज़्यादा फ़िक्रमंद हैं.

उन्होंने कहा, "एआई की तरक्की से खुद ब खुद लिए जाने वाले ऐसे फ़ैसलों की क्षमता बढ़ेगी जो पूर्वाग्रह वाले हैं, जिनमें भेदभाव होता है, लोगों को अलग थलग किया जाता है और निष्पक्ष नहीं होते हैं. जिनकी समीक्षा नहीं हो सकती और उन पर बहस नहीं होते."

उनके मुताबिक, "इससे मात्रा में बेतहाशा इजाफा होगा और ग़लत जानकारियां फैलेंगी. इससे हक़ीकत सही रूप में सामने नहीं आएगी. लोगों का भरोसा घटेगा. इससे असमानता और बढ़ेगी. खासकर उनके लिए जो डिजिटल तौर पर विभाजित दुनिया के कमज़ोर हिस्से की तरफ हैं."

इमेज स्रोत, Getty Images

क्या हो सुरक्षित रास्ता?

वो कहती हैं कि एआई के कई टूल 'अब तक के इंसानी अनुभव के लिहाज से फ्री राइड की तरह हैं.' इनमें से ज़्यादातर की ट्रेनिंग इंसान की बनाई सामग्री, टेक्स्ट, आर्ट और संगीत के जरिए हुई है. वो उसी के आधार पर काम करते हैं.

इन्हें तैयार करने वालों ने 'प्रभावी तरीके से तमाम दौलत और ताक़त को आम लोगों के बीच से हटाकर चंद निजी संस्थानों में लगाया है.'

लेकिन सेंटर फ़ॉर सेफ्टी के डायरेक्टर डटैन हेंड्राईक्स ने बीबीसी से कहा कि आने वाले वक़्त के जोखिम और आज की चिंताओं को 'परस्पर विरोधी के तौर पर नहीं देखा जाना चाहिए.'

वो कहते हैं, "कुछ मुद्दों को आज हल कर लिया जाए तो इससे आगे सामने आने वाले कई जोखिमों को हल करने में मदद मिल सकती है. "

इमेज स्रोत, Reuters

नई नहीं है चिंता

एआई के जरिए अस्तित्व पर संभावित ख़तरे को लेकर मार्च 2023 से बढ़ी है. तब टेस्ला के बॉस एलन मस्क समेत कई विशेषज्ञों ने एक खुला ख़त लिखा था. इसमें एआई तक़नीक की नेक्स्ट जेनरेशन के डेवलपमेंट को रोकने की गुजारिश की गई थी.

इस पत्र में सवाल किया गया था, 'क्या हमें ऐसे गैर इंसानी दिमाग तैयार करने चाहिए जो आगे जाकर संख्या में हमसे आगे निकल जाएं, हम से ज़्यादा स्मार्ट हों और हमारी जगह ले लें.'

इससे अलग नए अभियान के तहत बहुत छोटा सा बयान जारी किया गया है. इसमें 'चर्चा शुरू करने' की बात है.

इस बयान में ख़तरे की तुलना परमाणु युद्ध से की गई है. ओपनएआई के एक हालिया ब्लॉग में कहा गया है कि सुपरइंटेलिजेंस को न्यूक्लियर एनर्जी की ही तरह नियंत्रित किया जाना चाहिए.

ब्लॉग में लिखा गया है, "सुपरइंटेलिजेंस के लिए हमें आईएईए (इंटरनेशनल एटोमिक एनर्जी एजेंसी) जैसे किसी संगठन की ज़रुरत होगी."

इमेज स्रोत, Reuters

सुनक ने दिया भरोसा

सैम ऑल्टमैन और गूगल के चीफ़ एक्ज़ीक्यूटिव सुंदर पिचाई तकनीकी क्षेत्र के उन अगुवा लोगों में शामिल हैं जिन्होंने एआई को नियंत्रित करने के लिए हाल में ब्रिटेन के प्रधानमंत्री ऋषि सुनक से बात की है.

एआई के ख़तरों को लेकर दी गई हालिया चेतावनी के बारे में पत्रकारों से चर्चा करते हुए ऋषि सुनक ने अर्थव्यवस्था और समाज को होने वाले फ़ायदों पर ज़ोर दिया.

उन्होंने कहा, "आपने हाल में देखा कि ये लकवे के शिकार लोगों की चलने में मदद कर रहा था. नई एंटीबायोटिक्स की खोज कर रहा है लेकिन हमें ये तय करना होगा कि ये सब सुरक्षित तरीके से हो."

उन्होंने कहा, "यही वजह है कि मैं पिछले हफ़्ते सभी प्रमुख एआई कंपनियों के सीईओ से मिला ताकि हम चर्चा कर सकें कि हमें कौन से अवरोध लगाने हैं, किस तरह के नियंत्रण लगाए जाने चाहिए ताकि हम सुरक्षित रह सकें."

ब्रिटेन के पीएम ऋषि सुनक ने कहा कि उन्होंने जी7 समिट में दूसरे नेताओं के साथ इस मुद्दे पर चर्चा की और जल्दी ही अमेरिका में भी इस मुद्दे को उठाएंगे. जी7 ने हाल में एआई के लिए एक 'वर्किंग' ग्रुप बनाया है.

ये भी पढ़ें

(बीबीसी हिन्दी के एंड्रॉएड ऐप के लिए आप यहां क्लिक कर सकते हैं. आप हमें फ़ेसबुक, ट्विटर, इंस्टाग्राम और यूट्यूब पर फ़ॉलो भी कर सकते हैं.)