क्या रोबोट सीख सकता है सही-ग़लत में फर्क करना? - दुनिया जहान

इमेज स्रोत, mennovandijk

- Author, मानसी दाश

- पदनाम, बीबीसी संवाददाता

रेलवे ट्रैक पर सरपट दौड़ रही एक ट्रेन के ब्रेक फेल हो गए हैं. ट्रैक पर पांच लोग हैं. उन्हें बचाने के लिए आप ट्रैक बदल सकते हैं. लेकिन दूसरे ट्रैक पर एक आदमी काम कर रहा है और ट्रैक बदला तो उसकी मौत तय है.

आप क्या करेंगे- पांच जानें बचाएंगे या एक?

इस सवाल का जवाब आज आर्टिफ़िशियल इंटेलिजेंस के क्षेत्र में काम कर रहे वैज्ञानिकों बड़ा सरदर्द बन गया है. इसका जवाब अगर इंसानों के लिए मुश्किल है तो रोबोट क्या करेगा?

दुनिया जहान में आज पड़ताल इस बात की कि इस तरह की परिस्थिति में जहां फ़ैसले लेना इंसानों के लिए भी मुश्किल है वहां रोबोट फ़ैसले कैसे लेगा. हमारा सवाल है कि क्या रोबोट इंसानों की तरह सोच विचार कर फ़ैसले ले सकेगा?

जब हो जीने-मरने का सवाल

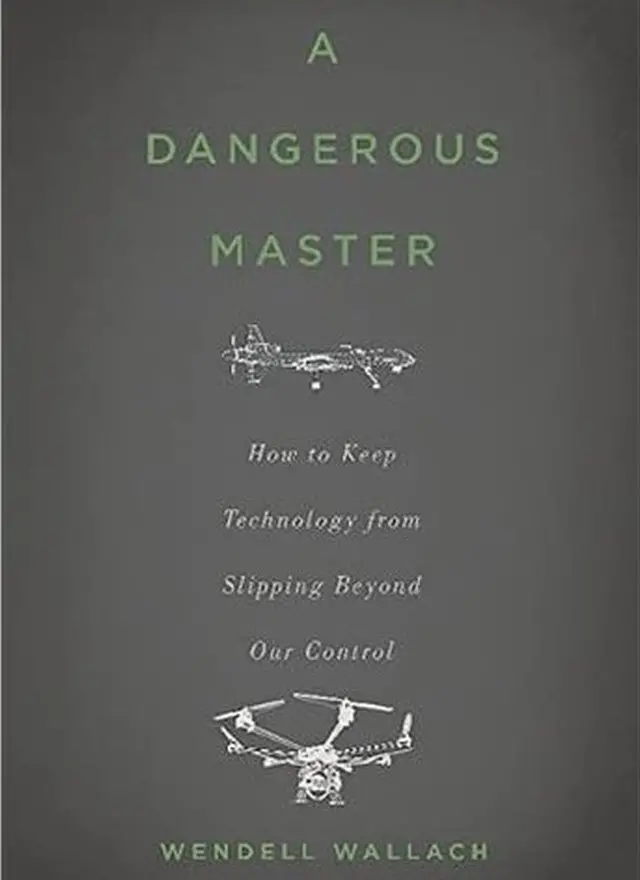

वेन्डल वॉलक येल युनिवर्सिटी में बीते कई सालों से तकनीक में नैतिकता यानी एथिक्स इन टेक्नोलॉजी पढ़ाते हैं.

अपनी क़िताब 'अ डेन्जरस मास्टर: हाओ टू कीप टेक्नोलॉजी फ्रॉम स्लिप्पिंग बियॉन्ड आवर कंट्रोल' में वेन्डल भविष्य की तकनीक और इसे काबू करने को लेकर चुनौतियों के बारे में चर्चा करते हैं.

वो ऐसे सवालों के जवाब तलाशते हैं जो इंसान के लिए बेहद मुश्किल होते हैं. जैसा हमने शुरूआत में पूछा- ट्रेन किसे बचाए- पांच लोगों को या एक व्यक्ति को. वेन्डल एक अलग रास्ता सुझाते हैं.

इमेज स्रोत, amazon.com

वेंडल वॉलक कहते हैं, "ट्रेन के लिए ट्रैक के ऊपर से होते हुए एक पुल बनाइए. फिर ट्रैक पर किसी व्यक्ति को धक्का दे दीजिए. इससे ट्रेन चला रहा रोबोट सतर्क हो जाएगा और पांच जानें बच जाएंगी."

सुनने में लगता है कि कुछ लोगों को बचाने के लिए एक की कुर्बानी देने से समस्या का हल निकल सकता है, लेकिन क्या ये सही होगा? असल में ये नैतिकता यानी एथिक्स का सवाल है.

समस्या के इस समाधान को उपयोगितावादी सही ठहरा सकते हैं, क्योंकि वो मानते हैं कि ज़्यादा लोगों के हित में कुछ की कुर्बानी जायज़ है. लेकिन कई इसे ग़लत करार देते हैं.

वो कहते हैं, "कुछ नैतिक मूल्य होते हैं जो अधिक लोगों का हित साबित करने वाले किसी भी तरह के आंकड़ों से ऊपर होते हैं."

तकनीक और नैतिकता के बीच का बड़ा सवाल यही है कि कौन-से नैतिक मूल्य और किसके. जैगुआर, फोर्ड, टेस्ला, हॉन्डा और वोल्वो जैसी कंपनियां बिना ड्राइवर की कार बनाने की होड़ में हैं. उनके सामने तकनीकी चुनौतियों के साथ-साथ ये सवाल भी है कि क्या रोबोट में सही-ग़लत का फ़ैसला लेने की क्षमता डाली जा सकती है.

- ये भी पढ़ें- भारत में कभी चल पाएंगी ऑटोमैटिक कारें?

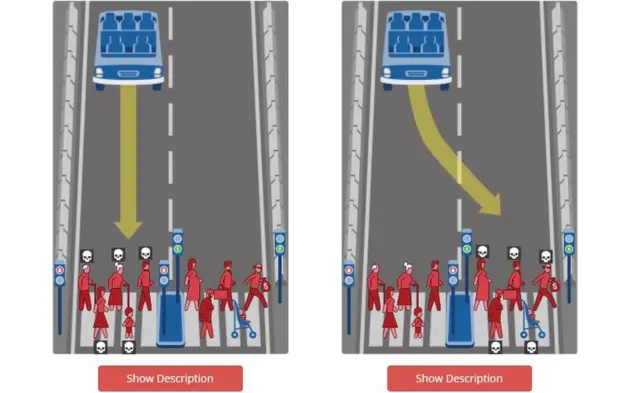

वेंडल वॉलक सवाल करते हैं, "अगर कार के आगे सिर्फ बच्चे हैं तो रोबोट क्या करेगा? अगर कार में सवार चार लोगों में एक बच्चा है और आगे चार लोग हैं तो वो किसे बचाएगा? क्या हो अगर रोबोट के हिसाब से दुर्घटना में कोई मौत नहीं होगी बस एक व्यक्ति घायल होगा. इस तरह के कई सवाल हो सकते हैं जिनका जवाब मुश्किल होता है."

रोज़मर्रा की ज़िंदगी में हमारे सामने ऐसे सवाल नहीं आते, लेकिन किसी दिन अचानक ये सवाल सामने आ सकते हैं, और ऐसे में फ़ैसला किसका होगा - कार निर्माता का, ड्राइवर का या फिर सरकार का.

इस तरह के सवालों पर लोगों की राय जानने के लिए मैसेचुसेट्स इंस्टीट्यूट ऑफ़ टेक्नोलॉजी ने मॉरल मशीन नाम की एक वेबसाइट बनाई.

वेंडल वॉलक बताते हैं, "उन्हें क़रीब 32 लाख जवाब मिले. कुछ की राय थी कि अधिक जानें बचाने के लिए कुछ की बलि देना सही है. लेकिन अधिकांश लोगों का कहना था कि वो ऐसी कार नहीं खरीदेंगे जो दुर्घटना की स्थिति में कार सवार को मारने का फ़ैसला ले सकती हो."

वेन्डल वॉलक कहते हैं इस सवाल का जवाब शायद ही किसी से पास हो. फिर भी, मान लेते हैं कि कुछ नैतिक सवालों के उत्तर पर हम एकमत हैं.

अब हमारे सामने दूसरा बड़ा सवाल है- क्या इन समाधानों को रोबोट में प्रोग्राम करना संभव है?

इमेज स्रोत, moralmachine.net

रोबोट और मानवाधिकार

साल 2004 में रोबोएथिक्स पर दुनिया के पहले अंततराष्ट्रीय सम्मेलन का आयोजन हुआ. सम्मेलन में युद्ध में रोबोट के इस्तेमाल और रोबोट इंसान का आदेश मानने से मना करे तो क्या हो, जैसे विषयों पर चर्चा हुई.

जॉर्जिया इंस्टीट्यूट ऑफ़ टेक्नोलॉजी में मोबाइल रोबोट लैबोरेटरी के निदेशक रॉनल्ड आर्किन्स भी इस सम्मेलन में शामिल हुए. यहां से लौटने के बाद उन्होंने रोबोट और नैतिकता विषय पर पढ़ाना शुरू किया.

वो रोबोटिक हथियारों के ख़तरों के बारे में चेतावनी देते हैं.

वो कहते हैं, "मैं हथियार के रूप में रोबोट के इस्तेमाल के ख़िलाफ़ हूं, मैं इस पर रोक लगाने के पक्ष में हूं. आप इसे काबू नहीं कर सकते और ये बेहद ख़तरनाक हो सकते हैं. कौन चाहेगा कि दुनिया में ऐसे हथियार मौजूद हों जो अपनी मर्ज़ी से किसी को मार सकते हों."

मिसाइलों के मामले में अब ऐसे हथियार बनने लगे हैं जो सामने से आ रहे ख़तरे को देख कर रास्ता बदल सकते हैं. हाल में रूस ने ऐसी मशीनगन बनाई है जो बिना इंसानी मदद के अपना टारगेट पहचान कर और उसे नष्ट कर सकती है.

- ये भी पढ़ें- मशीनों के दौर में नौकरी बचाने के तीन तरीके

इमेज स्रोत, Kalasnikov Gruop

लेकिन क्या नई पीढ़ी के इस तरह के रोबोटिक हथियारों में सही-ग़लत का फ़ैसला लेने का प्रोग्राम फिट किया जा सकता है?

आर्किन्स इसके पक्ष में हैं और मानते हैं कि रोबोट्स को मानवाधिकारों का सम्मान करना सिखाया जा सकता है.

वो कहते हैं, "हम मौजूदा नैतिक मूल्यों को देख सकते हैं और इन्हें रोबोट में प्रोग्राम कर सकते हैं, ताकि वो बेहतर फ़ैसले ले सकें. ठीक वैसे, जैसे किसी सैनिक को बंदूक देकर हम ये नहीं कहते कि किसे मारना है ये फ़ैसला वो खुद ले. हम उसे सही-ग़लत के बारे में सिखाते हैं और उम्मीद करते हैं कि वो इसी दायरे में काम करेगा. उसे बताया जाता है कि अलग-अलग परिस्थितियों में उसे किस आधार फ़ैसला लेना है."

तकनीकी स्तर पर ये बेहद मुश्किल है. आख़िर रोबोट कैसे समझेगा कि हाथ में चाकू लेकर खड़ा डॉक्टर व्यक्ति को बचा रहा है.

लेकिन आर्किन्स मानते हैं कि इन मुश्किल सवालों के बावजूद युद्ध में रोबोटिक हथियार बेहतर हैं क्योंकि वक्त पड़ने पर वो इंसानों से बेहतर फ़ैसले ले सकते हैं. रोबोट न तो किसी पर नाराज़ होते हैं, न कुंठा का शिकार होते हैं, उनमें जलन नहीं होती और वो बदला नहीं लेना चाहते. इसलिए रोबोट वो ग़लतियां नहीं करेंगे जो इंसान करते हैं.

इमेज स्रोत, Getty Images

लेकिन फिर, रोबोट प्यार और अपराध-बोध जैसी भावनाएं नहीं समझ सकते जो इंसान को ग़लतियां दोहराने से रोकती हैं.

रॉनल्ड आर्किन्स कहते हैं, "रोबोटिक हथियारों के इस्तेमाल से पहले इस बात पर विचार किया जाता है कि हमले में कितने आम नागरिक हताहत हो सकते हैं और कितनी संपत्ति को नुक़सान हो सकता है. ये बिल्कुल संभव है कि जितना अंदाज़ा हो, नुक़सान उससे अधिक हो. ऐसे में अपराध-बोध होगा तो सैनिक ग़लती नहीं दोहराएगा और हो सकता है कि वो फिर उस हथियार का इस्तेमाल न करे."

ये माना जा सकता है कि रोबोटिक हथियारों से लैस दो मुल्कों के बीच युद्ध आम नागरिकों के लिए घातक साबित हो सकता है. गणतांत्रिक मुल्कों के लिए इसके भयंकर राजनीतिक परिणाम हो सकते हैं.

वो कहते हैं, "मैं युद्ध नहीं चाहता. मैं नहीं चाहता कि ऐसे हथियारों का कभी इस्तेमाल हो. लेकिन अगर हम बेवकूफों की तरह एकदूसरे से लड़ना जारी रखेंगे तो मुझे लगता है कि आम नागरिकों को सुरक्षा के बेहतर रास्ते तलाशने चाहिए. हमें आम नागरिकों को बचाने की हरसंभव कोशिश करनी चाहिए."

आर्किन्स रोबोट के प्रोग्राम में अंतरराष्ट्रीय मानवाधिकारों के मूल्यों को भी जोड़ना चाहते हैं. लेकिन रोबोट को नैतिकता सिखाने का यही एकमात्र तरीका नहीं.

- ये भी पढ़ें- ये छोटा रोबोट लोगों की ज़िंदगियां बचा पाएगा?

किसके और कौन-से नैतिक मूल्य

सुज़ैन और माइकल एंडरसन केयरबॉट यानी इंसानों की मदद के लिए बने रोबोट के कॉन्सेप्ट पर काम कर रहे हैं. सुज़ैन फ़िलोसॉफ़र हैं, उनके पति माइकल कंप्यूटर साइंटिस्ट हैं.

दोनों एक एथिकल रोबोट बना रहे हैं यानी ऐसा रोबोट जिसके प्रोग्राम में नैतिकता के मूल्य जोड़े गए हों.

माइकल समझाते हैं, "केयरबॉट एक खास तरह का रोबोट होता है जो बुज़ुर्गों की मदद कर सकता है. आप घर में हों या बाहर, ये बॉट आपको याद दिलाता है कि आपको कब दवा लेनी है, कब टीवी देखना है. ये वो सारे काम करता है जिसके लिए आपको लोगों की मदद चाहिए."

इस लेख में Google YouTube से मिली सामग्री शामिल है. कुछ भी लोड होने से पहले हम आपकी इजाज़त मांगते हैं क्योंकि उनमें कुकीज़ और दूसरी तकनीकों का इस्तेमाल किया गया हो सकता है. आप स्वीकार करने से पहले Google YouTube cookie policy और को पढ़ना चाहेंगे. इस सामग्री को देखने के लिए 'अनुमति देंऔर जारी रखें' को चुनें.

पोस्ट YouTube समाप्त, 1

शोध के दौरान सुज़ैन और माइकल को एक वीडियो मिला जिसमें एक रोबोट एक बुज़ुर्ग महिला की मदद कर रही है.

इस वीडियो ने दोनों को कुछ हद तक डरा दिया.

सुज़ैन बताती हैं, "उस महिला के एक रिश्तेदार ने रोबोट को उनके घर पर देखा. कई बार उन्हें लगा कि महिला जो भी कर रही हैं वो कोई देख रहा है. ये एक तरह से उनकी निजता का ख़त्म होना था. हममें से अधिकांश लोगों को इस पर ऐतराज़ होगा क्योंकि ये एथिक्स का सवाल है."

माइकल कहते हैं कि ये एक बेहतरीन वीडियो था जो इस बात का उदाहरण था कि "एथिक्स के सवाल को इंजीनियरों पर छोड़ दिया जाए तो क्या हो सकता है."

- ये भी पढ़ें- रोबोट पनडुब्बियां समंदर में क्यों भेज रहा रूस?

इस लेख में Google YouTube से मिली सामग्री शामिल है. कुछ भी लोड होने से पहले हम आपकी इजाज़त मांगते हैं क्योंकि उनमें कुकीज़ और दूसरी तकनीकों का इस्तेमाल किया गया हो सकता है. आप स्वीकार करने से पहले Google YouTube cookie policy और को पढ़ना चाहेंगे. इस सामग्री को देखने के लिए 'अनुमति देंऔर जारी रखें' को चुनें.

पोस्ट YouTube समाप्त, 2

रॉनल्ड आर्किन्स की तरह सुज़ैन और माइकल मानते हैं कि रोबोट्स के प्रोग्राम में एथिक्स जोड़ना संभव है.

वो कहते हैं कि मशीन लर्निंग के ज़रिए रोबोट के प्रोग्राम में नैतिक मूल्य जोड़े जा सकते हैं जिनका आधार दूसरों को खुशी देना और झगड़ों से बचना हो. इसके बाद रोबोट परिस्थिति के अनुसार सही फ़ैसले ले सकता है.

सुज़ैन कहती हैं, "कभी-कभी छोटे से छोटा लगने वाला फ़ैसला भी बेहद महत्वपूर्ण हो सकता है. बैटरी ख़त्म होने की स्थिति में खुद को चार्ज करना मामूली बात है, लेकिन हो सकता है कि रोबोट को इससे पहले मरीज़ को दवा देने का काम करना हो."

सुज़ैन और माइकल के अनुसार रोबोट्स के प्रोग्राम में नैतिकता के वही मूल्य जोड़े जाने चाहिए जिन्हें लेकर वैश्विक स्तर पर विशेषज्ञों की सहमति बन सके. लेकिन वक्त के साथ नैतिकता के मानदंड भी बदलते हैं, जैसे कुछ सौ साल पहले दास प्रथा थी जो अब ग़लत है.

दूसरी तरफ हम ये मानते हैं कि रोबोट इंसान से अधिक ताकतवर और काबिल होंगे. हो सकता है कि नैतिकता के पैमाने पर भी वो इंसानों से बेहतर हों.

सुज़ैन कहती हैं, "मुझे लगता है कि कहीं ऐसा न हो कि रोबोट्स हमें ये आइना दिखाएं कि हम कैसा व्यवहार करते हैं. सच कहा जाए तो दुनिया में काफी तबाही इंसान में नैतिकता की कमी के कारण हुई है और उसने दूसरों के लिए भी मुश्किलें पैदा की हैं."

लौटते हैं अपने सवाल पर- क्या रोबोट्स को ऐथिक्स सिखाया जा सकता है. ऐसा करने के अलग-अलग तरीके हो सकते हैं, लेकिन सबसे पहले इस बात पर सहमति बनानी होगी कि वो कौन-से एथिक्स हैं जो सिखाने हैं.

लेकिन फिर, विशेषज्ञों को ये भी चिंता है कहीं रोबोट इंसान की तरह न बन जाए.

रोबोट वही करेगा जो सीखेगा

जोआना ब्रायसन बर्लिन के हर्टी स्कूल ऑफ़ गवर्नेंस में एथिक्स एंड टेकनोलॉजी की प्रोफ़ेसर हैं. वो रोबोट्स के मानवीकरण को भयानक कदम मानती हैं.

वो कहती हैं कि रोबोट्स को सीखा नहीं सकते, क्योंकि वो छात्र नहीं होते. वो वही करते हैं जो प्रोग्राम में लिखा होता है और ये कभी-कभी ग़लत भी हो सकता है.

वो कहती हैं, "डेमॉन्स्ट्रेशन के लिए हम इसकी प्रोग्रामिंग कर सकते हैं लेकिन इसे सिखाना नहीं कह सकते क्योंकि सिखाने की प्रक्रिया में लोगों के बीच इंसानी रिश्ते बनते हैं."

जोआना उदाहरण देती हैं कि अगर रोबोट को लाखों पंक्तियां का एक डेटाबेस दे दिया जाए और उसे इंसानों की नकल करने को कहा जाए, तो हो सकता है कि वो काम के आधार पर महिला और पुरुष के बीच का फर्क न कर सके.

वो कहती हैं, "महिलाओं को घरेलू काम से जोड़ कर देखा जाता है. ऐसे में हो सकता है कि रोबोट किचन और साफ-सफाई के काम को महिला के नाम से जोड़े और पुरुषों के नाम के साथ वो बाहर के काम जोड़ दे. लेकिन इसे उसकी ग़लती कहना सही नहीं होगा क्योंकि ये उस सामाजिक व्यवस्था के कारण है जो इंसान की बनाई हुई है. रोबोट उसी को तो दोहराएगा."

यानी रोबोट इंसानों की बनाई सामाजिक व्यवस्था और पूर्वाग्रहों से परे नहीं होगा बल्कि उसका हिस्सा बन जाएगा.

- ये भी पढ़ें- चीन में एआई सेंटर क्यों खोल रहा गूगल?

इमेज स्रोत, EPA/WU HONG

आप कह सकते हैं- रोबोट जो सीखेगा वही दोहराएगा, या कहें रोबोट को इंसान जो सिखाएगा वो वही दोहराएगा.

मतलब ये कि रोबोट्स को एथिक्स सिखाने के लिए इंसान को खुद अपनी बनाई व्यवस्था से लड़ना होगा और सही मायनों में एक न्यायपूर्ण समाज बनाना होगा. रोबोट्स की ग़लतियों के लिए एक तरह से उसे बनाने वाला ज़िम्मेदार होगा.

जोआना कहती हैं, "कुछ लोग ये दलील दे सकते हैं कि उन्होंने रोबोट्स को अच्छे से प्रोग्राम किया है, मशीन लर्निंग और डीप लर्निंग का इस्तेमाल किया है और रोबोट की ग़लती के लिए वो ज़िम्मेदार नहीं. लेकिन ये भी सही है कि अगर आपका पालतू कुत्ता किसी पर हमला करे तो वजह कोई भी हो, ज़िम्मेदार आप ही होते हैं."

यानी आप ये नहीं कह सकते कि मुझे नहीं पता मेरे रोबोट ने ये क्यों किया. और आर्टिफ़िशियन इंटेलिजेंस के क्षेत्र में यही वो अहम मोड़ है जहां सरकारों को दखल देने की ज़रूरत है.

वो कहती हैं, "आप आर्किटेक्ट का उदाहरण देख सकते हैं. दशकों पहले से उनके लिए नियम बनाए जाते रहे हैं. लोग नहीं चाहते कि इमारतें टूटें इसलिए आर्किटेक्ट को साबित करना होता है कि उसकी इमारत हर मौसम में खड़ी रहेगी. और तो और उन्हें कई तरह की इजाज़त लेनी होती है. तकनीक के क्षेत्र में भी यही करने की ज़रूरत है."

आप मानें या न मानें आने वाले वक्त में रोबोट्स कई छोटे-बड़े और महत्वपूर्ण फ़ैसले लेंगे. हम उम्मीद कर सकते हैं कि रोबोट्स के लिए एथिक्स को लेकर वैश्विक स्तर पर सहमति बन पाए.

हमें ये भी सुनिश्चित करना होगा कि रोबोट्स इंसानों की बनाई व्यवस्था का हिस्सा न बनें और उनके फ़ैसले पूर्वाग्रहों पर आधारित न हों.

लेकिन ये भी हो सकता है कि इस मामले में रोबोट एक कदम आगे साबित हों और वो हम इंसानों को और बेहतर इंसान बनाएं.

(बीबीसी हिन्दी के एंड्रॉएड ऐप के लिए आप यहां क्लिक कर सकते हैं. आप हमें फ़ेसबुक, ट्विटर, इंस्टाग्राम और यूट्यूब पर फ़ॉलो भी कर सकते हैं.)