Ces caméras qui devinent si vous êtes heureux ou une menace

Crédit photo, Affectiva

- Author, Par Daniel Thomas

- Role, Journaliste en technologie des affaires

- Temps de lecture: 5 min

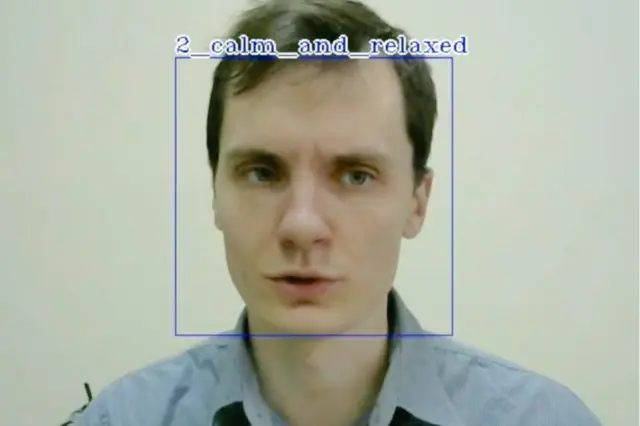

La technologie de la reconnaissance faciale devient de plus en plus sophistiquée, et certaines entreprises affirment qu'elle peut même lire nos émotions et détecter des comportements suspects.

Mais quelles sont les implications pour la vie privée et les libertés civiles ?

La technologie de reconnaissance faciale existe depuis des décennies, mais elle a progressé à pas de géant ces dernières années grâce aux progrès de la vision informatique et de l'intelligence artificielle (IA), affirment les experts technologiques.

Il est maintenant utilisé pour identifier les gens aux frontières, déverrouiller les téléphones tactiles, repérer les criminels et authentifier les transactions bancaires.

Lire aussi

Mais certaines entreprises de technologie prétendent qu'elle peut aussi évaluer notre état émotionnel.

Depuis les années 1970, les psychologues affirment qu'ils sont capables de détecter les émotions cachées en étudiant les "micro expressions" du visage de quelqu'un sur des photographies et des vidéos.

Les algorithmes et les caméras haute définition peuvent gérer ce processus avec autant de précision et de rapidité, affirment les entreprises de technologie.

"On le voit déjà utilisé à des fins commerciales ", explique Oliver Philippou, expert en vidéosurveillance chez IHS Markit.

Crédit photo, Apple

"Un supermarché pourrait l'utiliser dans les rayons, non pas pour identifier les gens, mais pour analyser qui est venu en termes d'âge et de sexe, ainsi que leur humeur de base.

Il peut aider à cibler le marketing et le placement de produits."

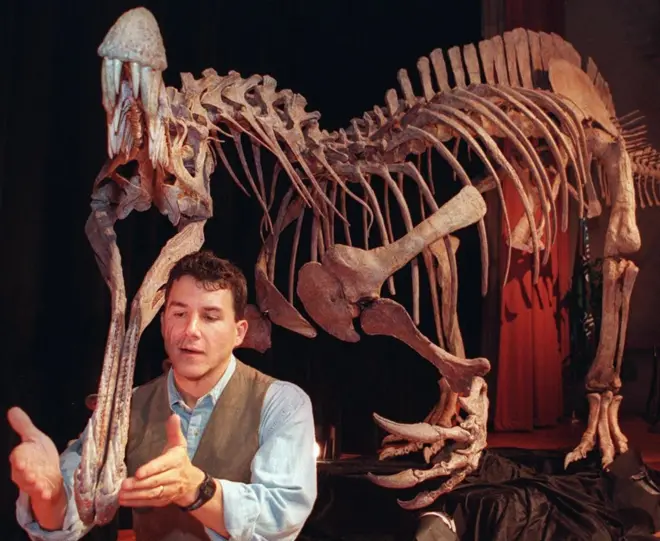

L'agence d'études de marché Kantar Millward Brown utilise une technologie développée par la société américaine Affectiva pour évaluer la réaction des consommateurs aux publicités télévisées.

Affectiva enregistre des vidéos des visages des gens - avec leur permission - puis "code" leurs expressions image par image pour évaluer leur humeur.

"Nous interrogeons les gens, mais nous obtenons beaucoup plus de nuances en regardant aussi leurs expressions. Vous pouvez voir exactement quelle partie d'une publicité fonctionne bien et la réaction émotionnelle qu'elle suscite ", explique Graham Page, directeur général de l'offre et de l'innovation chez Kantar Millward Brown.

Crédit photo, WeSee

De manière plus controversée, un grand nombre de start-up offrent une "détection d'émotions" à des fins de sécurité.

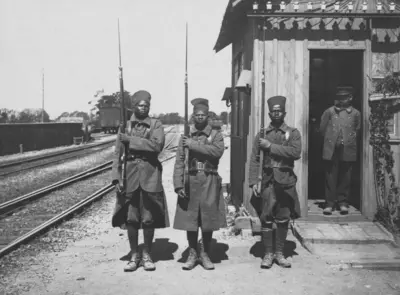

L'entreprise britannique WeSee, par exemple, affirme que sa technologie d'IA peut détecter les comportements suspects en lisant des indices faciaux imperceptibles à l'œil non averti.

Les émotions, comme le doute et la colère, peuvent être cachées sous la surface, contrairement à la langue utilisée par une personne.

WeSee dit qu'elle a travaillé avec une organisation "de haut niveau" dans le domaine de l'application de la loi afin d'analyser les personnes interrogées.

"En n'utilisant que des séquences vidéo de faible qualité, notre technologie a la capacité de déterminer l'état d'esprit ou l'intention d'un individu à travers ses expressions faciales, sa posture, ses gestes et ses mouvements ", déclare le directeur général David Fulton à la BBC.

"À l'avenir, les caméras vidéo installées sur la plate-forme d'une station de métro pourraient utiliser notre technologie pour détecter les comportements suspects et alerter les autorités sur une menace terroriste potentielle.

"La même chose pourrait être faite avec les foules lors d'événements comme les matchs de football ou les rassemblements politiques."

Mais M. Philippou est sceptique quant à la précision de la détection des émotions.

"Lorsqu'il s'agit simplement d'identifier les visages, il existe encore des marges d'erreur décentes - les meilleures entreprises prétendent pouvoir identifier les personnes avec une précision de 90 à 92 %.

"Quand on essaie aussi d'évaluer les émotions, la marge d'erreur augmente considérablement."

Cela inquiète les militants de la protection de la vie privée qui craignent que la technologie de reconnaissance faciale ne porte des jugements erronés ou biaisés.

"Bien que je puisse imaginer qu'il existe des cas d'utilisation vraiment utiles, les répercussions sur la vie privée découlant de la surveillance émotionnelle, de la reconnaissance faciale et du profilage facial sont sans précédent ", affirme Frederike Kaltheuner de Privacy International.

La reconnaissance faciale simple est déjà assez controversée.

Crédit photo, South Wales Police

Lorsque les fêtards ont assisté au premier programme "Biggest Weekend" de la BBC Radio à Swansea en mai, beaucoup ne savaient pas que leur visage était scanné dans le cadre d'une vaste opération de surveillance par la police du sud du Pays de Galles.

La force avait déployé son système d'identification faciale automatisée (AFR), qui utilise des caméras de type CCTV et un logiciel NEC pour identifier les "personnes d'intérêt " et comparer leurs visages à une base de données d'images de garde à vue.

Un homme faisant l'objet d'un mandat d'arrêt a été identifié et arrêté "dans les 10 minutes" suivant le déploiement de la technologie au festival de musique, explique Scott Lloyd, chef de projet AFR pour la police du sud du Pays de Galles.

This article contains content provided by X. We ask for your permission before anything is loaded, as they may be using cookies and other technologies. You may want to read the X cookie policy and privacy policy before accepting. To view this content choose 'accept and continue'.

Fin de X publication

Mais le groupe de défense des droits de l'homme Liberty souligne que la technologie a donné lieu à un grand nombre de "fausses positives" comparaisons lors d'autres événements, tels que la finale de la Ligue des champions à Cardiff l'année dernière.

En juillet, Ed Bridges, un résident de Cardiff - représenté par Liberty - a intenté une action en justice contre la force, soutenant que l'AFR violait la vie privée des gens et n'était pas suffisamment surveillée, ouvrant la voie à une bataille devant la Haute Cour.

Lire également;

Mais la technologie devient plus sure, selon Patrick Grother, responsable des tests biométriques au National Institute of Standards & Technology, une agence fédérale américaine qui fait des recherches sur la reconnaissance faciale.

Crédit photo, AFP

Il attribue les progrès technologiques récents au développement des "réseaux neuronaux convolutifs" - une forme avancée d'apprentissage machine qui permet un degré de précision beaucoup plus élevé.

"Ces algorithmes permettent aux ordinateurs d'analyser les images à différentes échelles et sous différents angles", dit-il.

"Vous pouvez identifier les visages avec beaucoup plus de précision, même s'ils sont partiellement masqués par des lunettes de soleil ou des foulards. Le taux d'erreur a décuplé depuis 2014, bien qu'aucun algorithme ne soit parfait."

M. Fulton de WeSee dit que sa technologie est simplement un outil pour aider les gens à évaluer les séquences vidéo existantes de manière plus intelligente.

Il ajoute que WeSee peut détecter les émotions sur les visages aussi efficacement qu'un humain le peut - "avec une précision d'environ 60%-70%".

Lire aussi

Crédit photo, Magnum Photos

"Pour l'instant, nous pouvons détecter les comportements suspects, mais non l'intention, afin d'empêcher que quelque chose de mal ne se produise. Mais je pense que c'est là où nous allons et nous faisons déjà des tests dans ce domaine."

Cela semble un pas de plus vers le concept de "pré-crime" présenté dans le film de science-fiction Minority Report, où des criminels potentiels sont arrêtés avant même que leurs crimes aient été commis.

Une autre préoccupation pour les organisations de défense des libertés civiles?

"La question clé que nous nous posons toujours est : qui construit cette technologie et à quelles fins ", déclare Frederike Kaltheuner, de Privacy International.

"Est-il utilisé pour nous aider -ou pour nous juger, nous évaluer et nous contrôler ?"