Les difficultés à identifier les images générées par l'intelligence artificielle lors des élections

Crédit photo, Getty Images

- Author, Luciani Gomes

- Role, BBC News Brésil

- Reporting from, Londres

Six doigts sur les mains, un visage qui ne semble pas appartenir au corps, un regard qui ne suit pas les mouvements, un bras qui bouge bizarrement.

Jusqu'à présent, il s'agit de problèmes courants avec les images synthétiques générées par l'intelligence artificielle (IA).

Les défauts apparents permettaient de détecter l'utilisation de l'IA d'un simple coup d'œil. Mais désormais, les experts préviennent que l'analyse humaine seule ne suffira plus dans ce processus.

« Cette fenêtre se referme », prévient Mike Speirs de Faculty AI, une société de conseil londonienne qui développe des modèles de détection des contenus synthétiques (produits par, ou avec l'aide de, l'IA).

« Les modèles sont constamment affinés en fonction de la nature presque conflictuelle entre ceux qui génèrent (le contenu) et ceux qui s'efforcent de l'identifier », ajoute-t-il.

End of A lire aussi sur BBC Afrique:

En cette année où une cinquantaine d'élections auront lieu dans le monde, y compris au Brésil, les experts et les gouvernements tentent de se préparer à l'utilisation possible de modèles d'IA pour créer des récits de désinformation afin d'influencer les résultats.

Le défi est de taille

Les modèles qui génèrent le contenu de l'IA apprennent des failles identifiées par les utilisateurs et les méthodes de détection.

Ainsi, les professionnels humains et les mécanismes mis au point pour détecter l'utilisation de l'IA dans un son ou une image fixe ou animée doivent suivre les améliorations apportées par les systèmes « adversaires » de création de contenu synthétique afin de comprendre les nouvelles failles et d'être ainsi en mesure de les repérer.

Au fur et à mesure que les modèles de génération et de détection de contenu évoluent, les défauts deviennent de moins en moins évidents, surtout à l'œil nu.

« Les façons dont nous comprenons aujourd'hui qu'un contenu est synthétique ne seront peut-être plus valables demain », déclare Carlos Affonso Souza, directeur de l'Institut de technologie de Rio de Janeiro, ajoutant toutefois que les applications les plus populaires ne tiennent toujours pas compte des mains qui ont plus de cinq doigts.

Crédit photo, DEEPFAKE GÉRÉ PAR L'IA

Une course aux armements

Des informations vérifiées à portée de main

Cliquez ici et abonnez-vous !

Fin de Promotion WhatsApp

Oren Etzioni, professeur émérite à l'université de Washington et chercheur en IA, est catégorique : « Il s'agit d'une course aux armements. Et nous avons atteint un point où il est extrêmement difficile de faire cette évaluation sans utiliser des modèles d'IA entraînés à cet effet. »

Cependant, l'accès aux outils de détection des contenus synthétiques ou manipulés est encore assez limité. En général, ils sont entre les mains de ceux qui peuvent les développer ou des gouvernements.

« Si vous n'avez aucun moyen de savoir ce qui est vrai, vous n'êtes pas dans une bonne position », ajoute-t-il.

M. Souza, de l'ITS-Rio, explique que l'un des défis consiste à former et à mettre à jour en permanence non seulement les modèles de détection pour reconnaître les contenus manipulés ou produits à l'aide de l'IA, mais aussi à éduquer les êtres humains qui y sont exposés.

« Nous sommes actuellement mal équipés, à la fois en termes de technologie et de méthodologie, pour faire face à ce débat », déclare-t-il. « Nous allons devoir utiliser des outils d'éducation numérique, en éduquant et en mettant à jour constamment la société sur le sujet. »

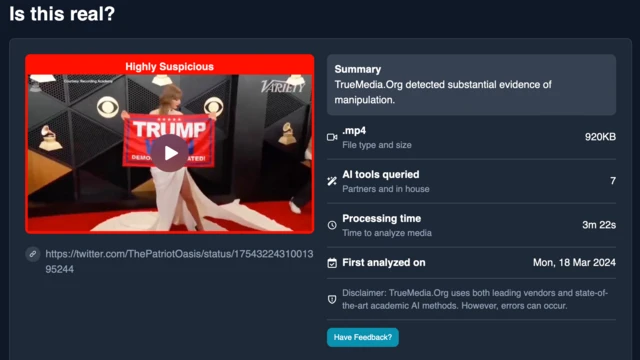

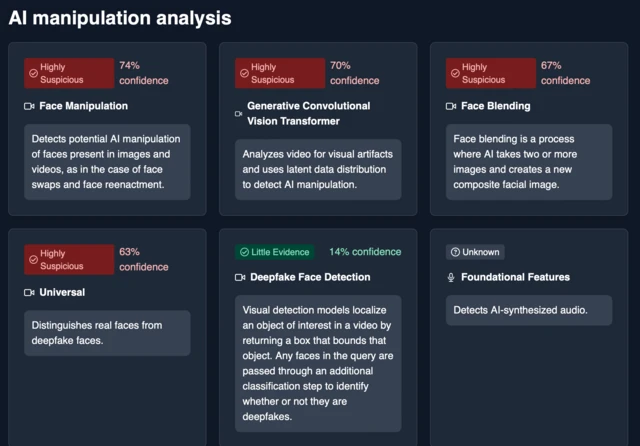

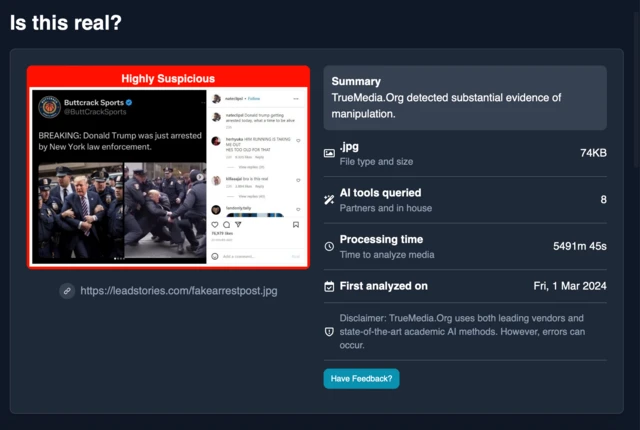

Crédit photo, True Media

Crédit photo, True Media

M. Speirs partage cet avis. « Il s'agit d'un problème de société plus large dans lequel la technologie joue un rôle important. Ainsi, en plus d'investir dans la détection, il faudrait également investir dans l'éducation aux médias ».

Etzioni est généralement optimiste quant à l'IA, mais reconnaît l'ampleur du problème, en particulier pour le processus électoral.

« Les réseaux sociaux nous ont donné la possibilité de partager facilement des informations. Mais la capacité de générer du contenu appartient toujours aux personnes. Avec l'IA, cela a changé et le coût de la production de contenu est tombé à zéro. Cette année sera cruciale pour nous permettre de comprendre le potentiel de cette technologie en matière de désinformation.

Craignant l'impact sur l'écosystème de l'information, notamment avec l'utilisation de « deep fakes » lors des élections présidentielles américaines, M. Etzioni a créé un outil de détection à but non lucratif, True Media, qui est proposé gratuitement aux journalistes.

Le contenu est analysé par les modèles d'IA de l'organisation en quelques minutes, et l'utilisateur reçoit une estimation de la probabilité que le contenu soit synthétique ou manipulé.

« Dans un monde où les gens peuvent être facilement manipulés, il est important que la presse fasse partie de la solution.

Crédit photo, True Media