J'ai créé cette « tante IA » pour les femmes après une tragédie familiale

Crédit photo, Grit

- Author, Megha Mohan

- Role, BBC World Service gender and identity correspondent

- Temps de lecture: 9 min

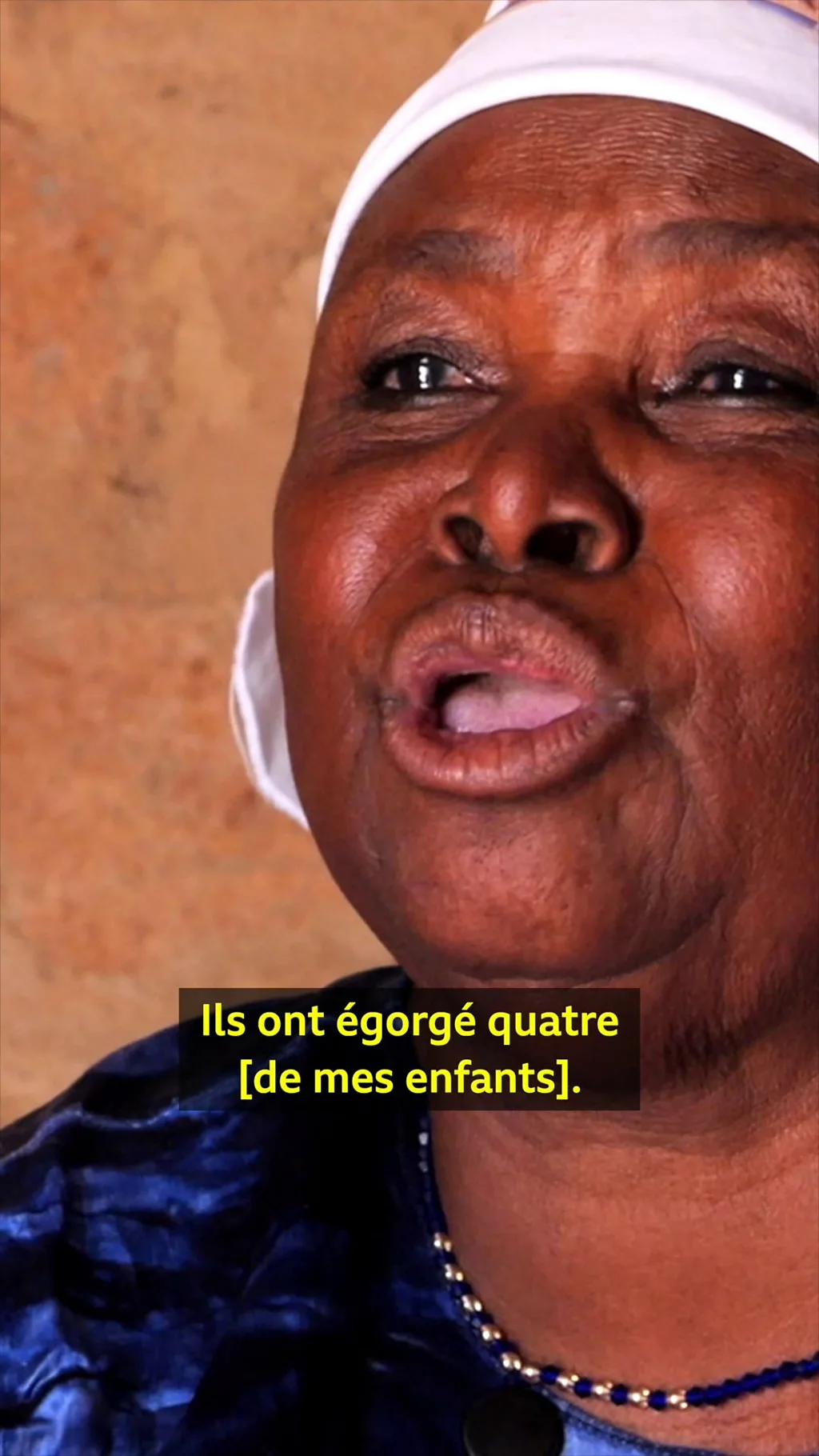

Un meurtre horrible au sein de sa propre famille a incité la Sud-Africaine Leonora Tima à créer une plateforme numérique où les gens, principalement des femmes, peuvent parler et signaler les cas de violence.

La parente de Leonora n'avait que 19 ans et était enceinte de neuf mois lorsqu'elle a été tuée, son corps abandonné sur le bord d'une autoroute près du Cap en 2020.

« Je travaille dans le secteur du développement, j'ai donc été témoin de violences », explique Leonora. « Mais ce qui m'a marquée, c'est que la mort violente d'un membre de ma famille était considérée comme tout à fait normale dans la société sud-africaine.

Sa mort n'a été relayée par aucun média, car le nombre de cas similaires dans notre pays est tel qu'ils ne sont pas considérés comme des informations dignes d'intérêt. »

Le meurtrier n'a jamais été arrêté et ce que Leonora a perçu comme une acceptation silencieuse de la mort violente d'une femme a été le catalyseur de son application, Gender Rights in Tech (Grit), qui comprend un chatbot appelé Zuzi.

Il s'agit de l'un des premiers outils d'IA gratuits créés par des développeurs africains pour lutter contre la violence sexiste.

« C'est une solution africaine conçue en collaboration avec les communautés africaines », explique Leonora.

L'objectif est d'offrir un soutien et d'aider à recueillir des preuves qui pourraient ensuite être utilisées dans des procédures judiciaires contre les auteurs de violences.

Des informations vérifiées à portée de main

Cliquez ici et abonnez-vous !

Fin de Promotion WhatsApp

Cette initiative suscite l'intérêt des militantes internationales des droits des femmes, même si certaines mettent en garde contre le fait que les chatbots ne doivent pas remplacer le soutien humain, soulignant que les victimes ont besoin d'empathie, de compréhension et d'un lien émotionnel que seul un professionnel qualifié peut leur apporter.

Leonora et sa petite équipe ont rendu visite à des communautés dans les townships autour de son domicile au Cap, discutant avec les habitants de leurs expériences en matière d'abus et de la place de la technologie dans leur vie.

Ils ont interrogé plus de 800 personnes sur la manière dont elles utilisaient leur téléphone et les réseaux sociaux pour parler de la violence, et sur ce qui les empêchait de demander de l'aide.

Leonora a constaté que les gens voulaient parler des abus dont ils étaient victimes, mais « ils se méfiaient des voies traditionnelles telles que la police ».

« Certaines femmes publiaient des messages à ce sujet sur Facebook et taguaient même leur agresseur, pour finalement se voir signifier des poursuites pour diffamation », explique-t-elle.

Elle estimait que les systèmes existants faisaient doublement défaut aux victimes, d'abord en ne parvenant pas à prévenir la violence elle-même, puis à nouveau lorsque les victimes tentaient de s'exprimer.

Grâce au soutien financier et technique de Mozilla, de la Fondation Gates et de la Fondation Patrick McGovern, Leonora et son équipe ont commencé à développer Grit, une application mobile qui permet aux victimes d'enregistrer, de signaler et d'obtenir une réponse aux abus pendant qu'ils se produisent.

L'application est gratuite, mais son téléchargement nécessite une connexion mobile. L'équipe de Leonora affirme compter 13 000 utilisateurs et avoir reçu environ 10 000 demandes d'aide en septembre.

Grit s'articule autour de trois fonctionnalités clés.

Sur l'écran d'accueil se trouve un gros bouton d'aide circulaire. Lorsqu'on appuie dessus, il commence automatiquement à enregistrer 20 secondes d'audio, capturant ce qui se passe autour de l'utilisateur. En même temps, il déclenche une alerte vers un centre d'appel privé à réponse rapide - les sociétés d'intervention professionnelle sont courantes en Afrique du Sud - où un opérateur qualifié appelle l'utilisateur.

Si l'appelant a besoin d'une aide immédiate, l'équipe d'intervention envoie quelqu'un sur place ou contacte une organisation locale qui peut venir en aide à la victime.

L'application a été conçue pour répondre aux besoins des victimes d'abus, explique Leonora : « Nous devons gagner la confiance des gens. Ce sont des communautés qui sont souvent ignorées. Nous demandons beaucoup aux gens lorsqu'il s'agit de partager des données. »

Crédit photo, Grit

Lorsqu'on lui demande si la fonction d'aide a été utilisée à mauvais escient, elle admet qu'il y a eu quelques cas de curiosité, des personnes qui ont testé le système pour voir s'il fonctionnait vraiment, mais rien qu'elle qualifierait d'abus.

« Les gens sont prudents. Ils nous testent autant que nous testons la technologie », dit-elle.

Le deuxième élément de Grit est « le coffre-fort » qui, selon Leonora, est un espace numérique sécurisé où les utilisateurs peuvent stocker des preuves d'abus, datées et cryptées, en vue d'une éventuelle utilisation ultérieure dans le cadre de procédures judiciaires.

Les photos, captures d'écran et enregistrements vocaux peuvent tous être téléchargés et enregistrés de manière privée, protégeant ainsi les preuves cruciales contre toute suppression ou altération.

« Parfois, les femmes prennent des photos de leurs blessures ou enregistrent des messages menaçants, mais ceux-ci peuvent être perdus ou supprimés », explique Leonora. « Grâce au coffre-fort, les preuves ne sont pas simplement stockées sur un téléphone qui pourrait être confisqué ou détruit. »

Ce mois-ci, Grit va encore s'agrandir avec le lancement de sa troisième fonctionnalité : Zuzi, un chatbot alimenté par l'IA conçu pour écouter, conseiller et orienter les utilisateurs vers les services d'aide locaux.

« Nous avons demandé aux gens : « Devrait-il s'agir d'une femme ? D'un homme ? D'un robot ? Devrait-il parler comme un avocat, un travailleur social, un journaliste ou une autre figure d'autorité ? » », explique Leonora.

Les gens leur ont répondu qu'ils voulaient que Zuzi soit « une figure maternelle », quelqu'un de chaleureux et de confiance, à qui ils pourraient se confier sans craindre d'être jugés.

Crédit photo, Grit

Bien qu'il ait été conçu principalement pour les femmes victimes de violence, Zuzi a également été utilisé par des hommes en quête d'aide pendant la phase de test.

« Certaines conversations proviennent d'agresseurs, des hommes qui demandent à Zuzi de leur apprendre à gérer leur colère, qu'ils dirigent souvent vers leur partenaire », explique Leonora. « Il y a aussi des hommes victimes de violence qui ont utilisé Zuzi pour parler plus ouvertement de leur expérience.

Les gens aiment parler à l'IA parce qu'ils ne se sentent pas jugés par elle », ajoute-t-elle. « Ce n'est pas un être humain. »

Selon ONU Femmes, l'Afrique du Sud connaît l'un des taux de violence sexiste les plus élevés au monde, avec un taux de féminicide cinq fois supérieur à la moyenne mondiale. Entre 2015 et 2020, sept femmes en moyenne ont été tuées chaque jour, selon la police sud-africaine.

Beaucoup, dont Lisa Vetten, spécialiste de la violence sexiste en Afrique du Sud, s'accordent à dire qu'il est inévitable que la technologie joue un rôle dans la lutte contre ce fléau.

Mais elle met également en garde contre l'utilisation de l'IA dans les soins centrés sur les traumatismes.

« Je les appelle « grands modèles linguistiques », et non « intelligence artificielle », car ils se livrent à des analyses et des prédictions linguistiques, rien de plus », explique-t-elle.

Elle comprend comment les systèmes d'IA peuvent être utiles, mais connaît des exemples où d'autres chatbots IA ont donné des conseils erronés à des femmes.

« Je m'inquiète lorsqu'ils donnent aux femmes des réponses très assurées à leurs problèmes juridiques », dit-elle. « Les chatbots peuvent fournir des informations utiles, mais ils sont incapables de traiter des difficultés complexes et multifacettes. Plus important encore, ils ne peuvent pas remplacer le conseil humain. Les personnes qui ont subi des préjudices ont besoin d'aide pour faire confiance et se sentir en sécurité avec d'autres êtres humains. »

Crédit photo, @judith.Litvine/MEAE

L'approche de Grit a attiré l'attention internationale.

En octobre, Leonora et son équipe ont présenté leur application lors de la Conférence sur la politique étrangère féministe organisée par le gouvernement français à Paris, où des dirigeants mondiaux se sont réunis pour discuter de la manière dont la technologie et la politique peuvent être utilisées pour construire un monde plus égalitaire entre les sexes. Lors de la conférence, 31 pays ont signé un engagement à faire de la lutte contre la violence sexiste une priorité politique majeure.

Les discussions vont bon train autour de l'utilisation de l'IA, explique Lyric Thompson, fondatrice et directrice du Feminist Foreign Policy Collaborative, « mais dès que vous essayez d'inclure la question du genre dans la conversation, pour souligner les dangers des préjugés racistes, sexistes et xénophobes qui y sont intégrés, les regards se voilent et la conversation dérive, probablement vers une arrière-salle où aucune femme importune ne viendra la relancer ».

Heather Hurlburt, chercheuse associée à Chatham House, spécialisée dans l'IA et son utilisation dans le domaine technologique, reconnaît que l'IA « a un énorme potentiel pour aider à identifier et à corriger la discrimination et la violence sexistes, ou pour renforcer la misogynie et les inégalités », mais ajoute que la direction que nous prendrons « dépendra en grande partie de nous ».

Leonora est convaincue que le succès de l'IA dans la lutte contre la violence sexiste ne dépend pas seulement de l'ingénierie, mais aussi de ceux qui conçoivent la technologie en premier lieu.

Un rapport du Forum économique mondial de 2018 a révélé que seulement 22 % des professionnels de l'IA dans le monde étaient des femmes, une statistique qui est encore souvent citée.

« L'IA telle que nous la connaissons aujourd'hui a été construite à partir de données historiques qui privilégient les voix des hommes, et en particulier des hommes blancs », explique Leonora.

« La solution ne consiste pas seulement à avoir davantage de femmes créatrices. Nous avons également besoin de créatrices issues des minorités ethniques, davantage originaires des pays du Sud et issues de milieux socio-économiques moins privilégiés. »

Ce n'est qu'alors, conclut Leonora Tima, que la technologie pourra commencer à refléter la réalité de ceux qui l'utilisent.

Crédit photo, Getty Images/BBC